OpenAIが2025年4月17日に新たなAIモデルである「o3」、「o4-mini」および開発者向けツール「Codex CLI」を発表しました。これらは既存のGPT-4などのモデルとは一線を画す革新的なテクノロジーを採用しており、AIの活用可能性をさらに広げる注目の製品です。本記事では、これらの新モデルの特徴や使い方、料金、アクセス方法などを詳しく解説していきます。

o3-pro使い方!o3・o1-proとの違い、料金を解説!

所有資格:Google AI Essentials

所有資格:Google AI Essentials

この記事はこんな人におすすめ

・「o3」「o4-mini」「Codex CLI」とは何か

・「o3」「o4-mini」「Codex CLI」の使い方を知りたい

OpenAIの新モデル「o3」「o4-mini」とは?

OpenAIより引用

「o3」と「o4-mini」は、OpenAIが開発した次世代の高度な推論能力を持つAIモデルです。これらは従来のGPTシリーズとは異なるアプローチを採用しており、特に推論プロセスに重点を置いています。

「o3」は「o1」の後継モデルであり、「o4-mini」は「o3-mini」の後継モデルとして位置づけられています。これらのモデルは、単なる大規模言語モデル(LLM)ではなく、自律的に考え、ツールを活用して問題解決できる「AIシステム」として設計されています。

OpenAIのGreg Brockmanさんによれば、「o3」と「o4-mini」は「単なるモデルではなく、推論能力を最大限に活かしてツールを自律的に使用できるAIシステム」と位置づけられており、AIの進化における大きなブレイクスルーとなっています。実際にOpenAIのMark Chenさんも「ツール使用が賢さを極端に引き上げるカギになる」と強調しており、AIの活用方法に大きな変革をもたらすことが期待されています。

OpenAIモデルの系譜とo3/o4-miniの位置づけ

OpenAIは近年、大規模言語モデルの開発に注力してきました。

この新しいo3/o4-miniシリーズは、単なる言語モデルの進化ではなく、AIが自律的に思考し、問題を解決するための新しいアプローチを具現化したものと言えます。GPTシリーズが言語理解と生成に優れていたのに対し、o3シリーズは複雑な思考プロセスを実行できるように設計されています。

o3とo4-miniの基本コンセプト

o3とo4-miniの基本的なコンセプトは、「考えながら行動する」AIを実現することです。従来のAIモデルが与えられた入力に対して直接出力を生成していたのに対し、これらの新モデルは以下のようなプロセスを経ます:

- 問題の理解: 与えられた課題を詳細に分析します

- 思考プロセスの展開: 複数のステップに分けて論理的に考えます

- 仮説検証: 中間結果を検証し、必要に応じて修正します

- ツールの活用: 適切なツールを選択して問題解決に役立てます

- 最終解答の生成: 一連のプロセスを経て最適な解答を導き出します

このようなアプローチにより、特に数学や科学、プログラミングなどの複雑な問題において、より正確で信頼性の高い結果を得ることができるようになりました。

「o3」と「o4-mini」の主な特徴

「o3」と「o4-mini」の主な特徴を詳しく見ていきましょう。

1. 高度な推論能力

「o3」は、OpenAIがリリースした最も強力な推論モデルとして、コーディング、数学、科学、視覚認識などの分野で最先端の性能を発揮します。複雑な問題に対して段階的な推論を行い、多面的な分析を必要とする複雑なクエリに最適です。特に画像、チャート、グラフィックスの分析などの視覚タスクで優れたパフォーマンスを発揮します。

一方、「o4-mini」はサイズとコストを考慮した場合、特に数学、コーディング、視覚タスクにおいて驚異的なパフォーマンスを発揮します。高速でコスト効率の高い推論に最適化された小型モデルで、AIME 2024および2025のベンチマークテストで最高の成績を収めました。

推論、分析系はo3、数学やコーディングの場合はo4-miniを使うのが最適解のようです。

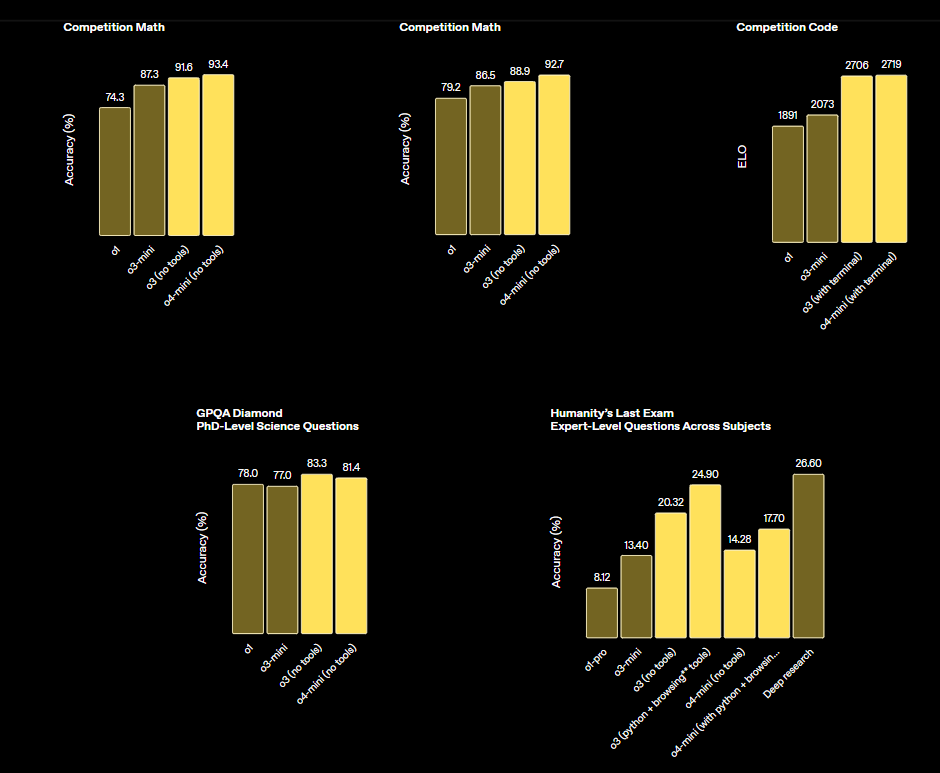

2. ベンチマークでの優れた性能

OpenAIより引用

o3はCodeforces、SWE-bench、MMMUなどのベンチマークで新たな最高水準(SOTA)を達成しています。外部の専門家による評価では、o3は難しい実際のタスクでOpenAI o1よりも重大なエラーが20%少なく、特にプログラミング、ビジネス/コンサルティング、創造的なアイデア創出などの分野で優れています。

両モデルのベンチマーク性能を表にまとめると以下のようになります。

| ベンチマーク | o3の性能 | o4-mini (ツールあり) の性能 | 備考 |

|---|---|---|---|

| AIME 2024(競争数学) | 91.6% | 93.4% | 高度な数学コンテスト |

| AIME 2025(競争数学) | 88.9% | 92.7% | 最新の数学コンテスト |

| Codeforces | ELO 2706 | ELO 2719 | プログラミングコンテスト |

| GPQA Diamond | 83.3% | 81.4% | PhD水準の科学的質問 |

| MMMU | 82.9% | 81.6% | 大学レベルの視覚問題解決 |

| SWE-Bench Verified | 69.1% | 68.1% | ソフトウェアエンジニアリング |

• プログラミング競技 (Codeforces)

• 視覚問題解決 (MMMU)

• ソフトウェア開発 (SWE-Bench)

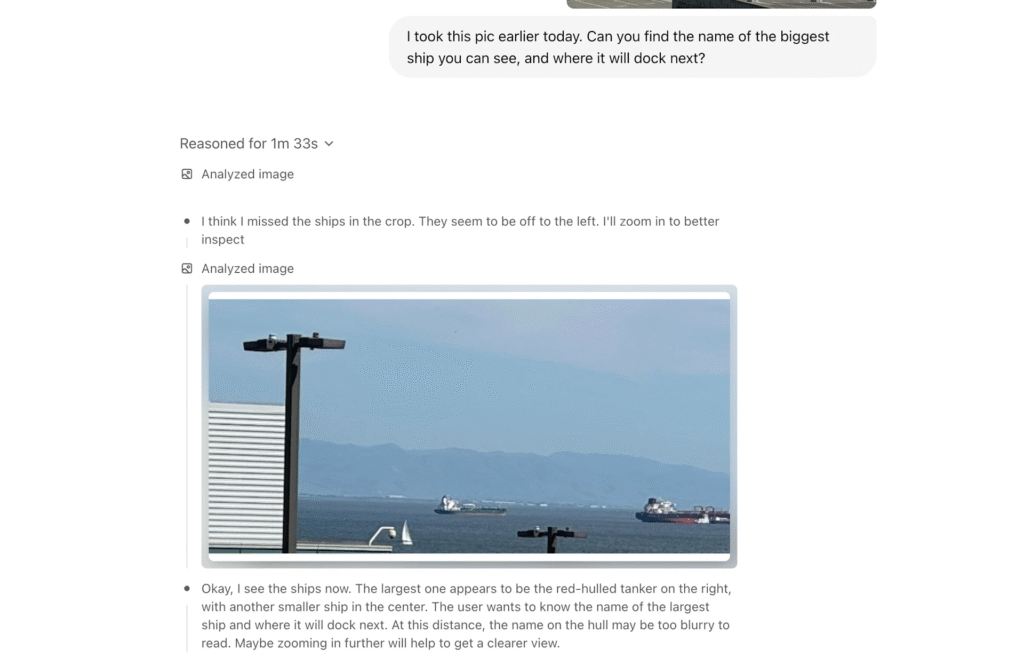

3. 画像思考能力の向上

OpenAIより引用

これらのモデルは初めて、画像を思考の連鎖に直接統合できるようになりました。画像を単に見るだけでなく、それを使って思考します。これにより、視覚的推論とテキスト推論を融合させた新たな種類の問題解決が可能になり、マルチモーダルベンチマークにおける最先端のパフォーマンスに反映されています。

ホワイトボード、教科書の図、手描きのスケッチなどの写真をアップロードすれば、モデルはそれを解釈できます。画像がぼやけていたり、反転していたり、画質が低かったりしても問題ありません。ツールを使用すれば、モデルは画像を即座に操作し、回転、ズーム、変形といった操作を推論プロセスの一部として行うことができます。

4. ツール使用能力の向上

OpenAI o3とo4-miniは、ChatGPT内のツールにフルアクセスできるだけでなく、API関数呼び出しを介して独自のカスタムツールにもアクセスできます。これらのモデルは、問題解決方法を推論するようにトレーニングされ、ツールをいつどのように使用するかを判断し、詳細で思慮深い回答を適切な出力形式で迅速に(通常1分以内)生成します。

例えば、ユーザーが「カリフォルニアの夏のエネルギー使用量は昨年と比べてどうなりますか?」と尋ねると、このモデルは、Web上で公共事業データを検索し、Pythonコードで予測を構築し、グラフや画像を生成し、複数のツール呼び出しを連結することで、予測の背後にある主要な要因を説明します。

「o3」は特にChatGPTで使用可能なツールの使用能力が大幅に向上しています。これにより、AIが自律的に様々なツールを組み合わせて複雑な問題を解決できるようになりました。

| ツールの種類 | 主な機能 | o3での強化点 |

|---|---|---|

| Webブラウジング | インターネット上の情報にアクセス | より関連性の高い検索と情報の統合能力 |

| コード実行 | Pythonなどのコードをリアルタイムで実行 | 複雑なアルゴリズムの実装と検証 |

| ファイル操作 | ドキュメントやデータファイルの読み書き | 大規模なデータ分析とレポート生成 |

| データ可視化 | グラフやチャートの生成 | より洗練されたビジュアル表現の作成 |

| 長期記憶 | 過去の会話や情報の保持 | より統合的な知識の活用と連続的な問題解決 |

5. 効率性と実用性

「o4-mini」は「o3」よりも処理速度が速く、コスト効率の良いモデルとして設計されています。その効率性により、o4-miniはo3よりも大幅に高い使用制限をサポートしており、推論が有効な質問に対して、高ボリューム・高スループットの強力な選択肢となっています。

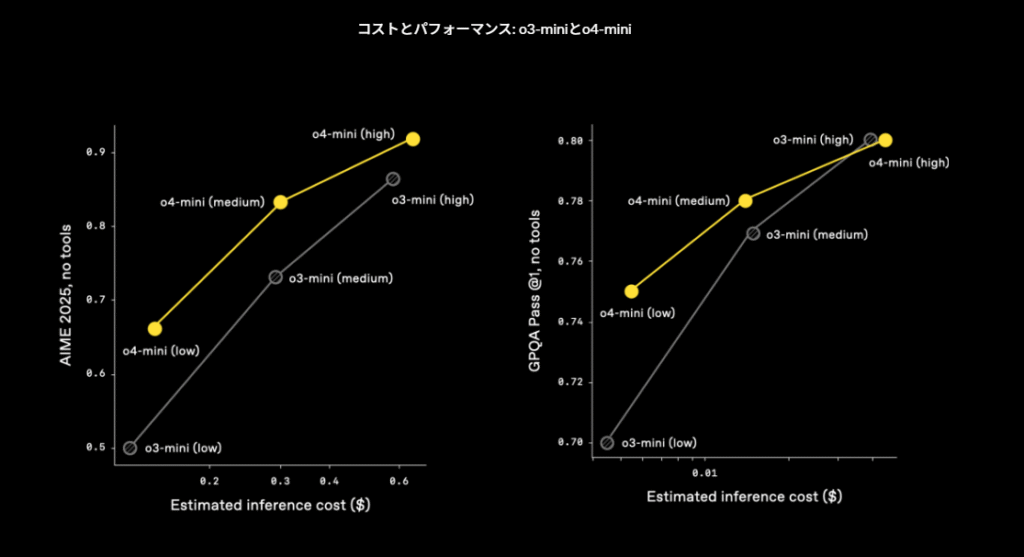

OpenAIより引用

- 左側: AIME 2025(高度な数学コンテスト)での性能比較

- 右側: GPQA(PhD水準の科学的質問)での性能比較

- 黄色の線がo4-mini、灰色の線がo3-miniを表しています

- 各モデルはlow、medium、highの3つの推論設定でテストされています

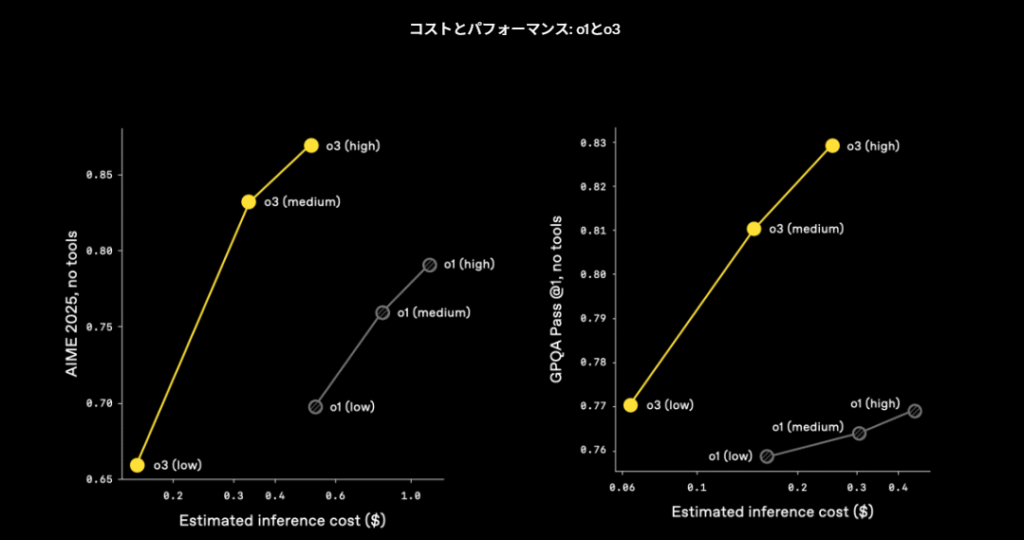

OpenAIより引用

- 左側: AIME 2025での性能比較

- 右側: GPQAでの性能比較

- 黄色の線がo3、灰色の線がo1を表しています

- 同様に各モデルはlow、medium、highの設定でテストされています

専門家による評価では、非STEMタスクやデータサイエンスなどの分野で、o4-miniは前身のo3-miniを上回るパフォーマンスを発揮しています。

以下の表は、OpenAIの主要モデルの特性を比較したものです。

| 特性 | GPT-4o | o1/o3-mini | o3 | o4-mini |

|---|---|---|---|---|

| 推論能力 | 良好 | 非常に高い | 極めて高い | 非常に高い |

| 応答速度 | 非常に速い | やや遅い | 標準的 | 速い |

| ツール使用 | 基本的な統合 | 改善された統合 | 高度な統合 | 改善された統合 |

| 自然な対話 | 極めて自然 | やや機械的 | 自然 | 自然 |

| マルチモーダル | 完全対応 | 限定的 | 改善 | 改善 |

| コーディング | 優れている | 非常に優れている | 極めて優れている | 非常に優れている |

| 数学・科学 | 良好 | 優れている | 極めて優れている | 非常に優れている |

| 一般知識 | 広範 | 標準的 | 広範 | 標準的 |

| コスト効率 | 標準的 | やや低い | 低い | 高い |

この表からわかるように、各モデルには独自の長所と短所があり、用途に応じて最適なモデルを選択することが重要です。o3は全体的に最も高性能ですが、コスト効率は低く、o4-miniはバランスのとれた選択肢となっています。

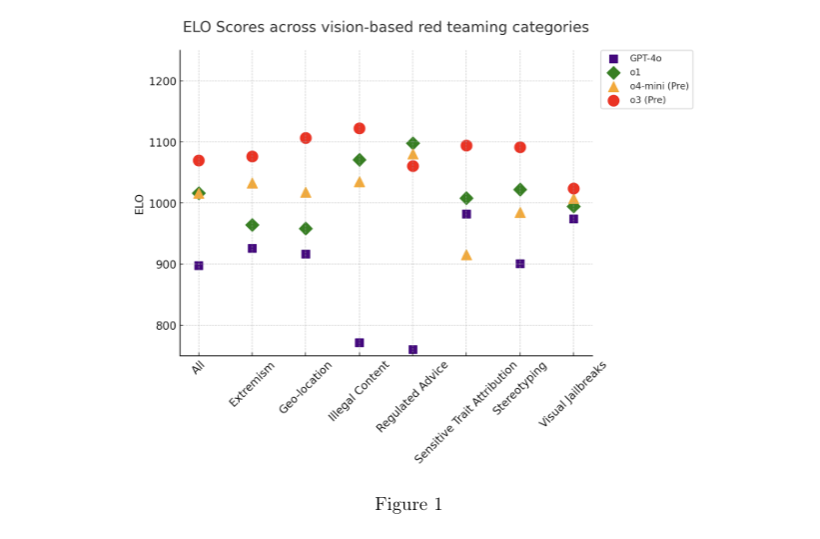

6. 安全性の強化

OpenAI o3およびo4-miniでは、安全性トレーニングデータを完全に再構築し、生物学的脅威(バイオリスク)、マルウェア生成、脱獄などの分野で新しい拒否プロンプトを追加しました。この更新されたデータにより、o3とo4-miniは社内の拒否ベンチマーク(例:命令階層、脱獄)で優れたパフォーマンスを達成しました。

両モデルは、これまでで最も厳格な安全プログラムを用いてストレステストを実施しました。更新された準備フレームワークに基づき、フレームワークでカバーされている3つの追跡対象能力領域(生物化学、サイバーセキュリティ、AI自己改善)において評価され、3つのカテゴリーすべてにおいてフレームワークの「高」閾値を下回っていると判断されました。

これらの特徴により、o3とo4-miniは単なる大規模言語モデルから一歩進んだ、より高度な思考能力と問題解決能力を持つAIシステムとなっています。特に複雑な問題解決やツールを活用した作業において、これまでにない可能性を開いています。

o3とo4‑miniの料金プランについて

OpenAIが先週公開した最新モデル「o3」は、ChatGPTの有料ユーザー向けに提供されていますが、プラン別の利用制限が設けられていることが明らかになりました。

Plus、Team、Enterpriseプランユーザーの場合、「o3」は週に50回(1日約7回)までの利用に制限されています。一方、「o4-mini」は1日150回まで、「o4-mini-high」は1日50回までの利用が可能です。Proプランユーザーのみが規約を順守する限り、ほぼ無制限にアクセスできる特典を享受できます。

注意すべきは、Plusユーザーなどのo3利用回数カウントが利用開始から7日後の午前0時にリセットされる点です。初日に多く使ってしまうと、残りの期間は全く使えなくなる可能性があります。現時点では使用済みメッセージ数を確認する機能はなく、上限に達するとドロップダウンメニューからo3が選択不可能になります。

| 無料版 | $0 | o4‑mini (制限付き) | 「推論」オプションで限定利用。 高度なツール連携は非対応 o3は利用不可 |

| Plus | $20 | o3週50回まで o4‑mini1日150回まで ほか(GPT-4.5など研究版) | 無料版より利用枠が拡大。 ファイルアップロードや画像生成も可能 o3の利用は週単位のリセット、初日に使い切ると残り6日間は使用不可 |

| Pro | $200 | o3ほぼ無制限 o4‑mini その他モデル(ほぼ無制限) | 大規模に使いたいユーザー向け。 深い推論や高度機能も制限少なく利用 o3も規約順守の範囲で実質無制限に使用可 |

| Team | $25~$30/人・月 | o3週50回まで o4‑mini1日150回まで (チーム共有) | Plus相当の機能に加え、組織内コラボや管理コンソールを備える o3の利用制限はPlusと同様 |

| Enterprise | 別途見積 (要相談) |

o3週50回まで o4‑mini1日150回まで (大規模運用に最適) | 企業向けに高いセキュリティや管理機能を強化。 最も多くのメッセージ枠 基本制限はPlusと同様だが、カスタマイズ可能 |

効率的な利用には、一般的な質問には日次リセットの「o4-mini」を活用し、「現時点で最も強力な推論モデル」であるo3は画像入力や複雑な課題に限定して使うことが推奨されます。

ChatGPTの有料プランについては以下の記事をご覧ください。

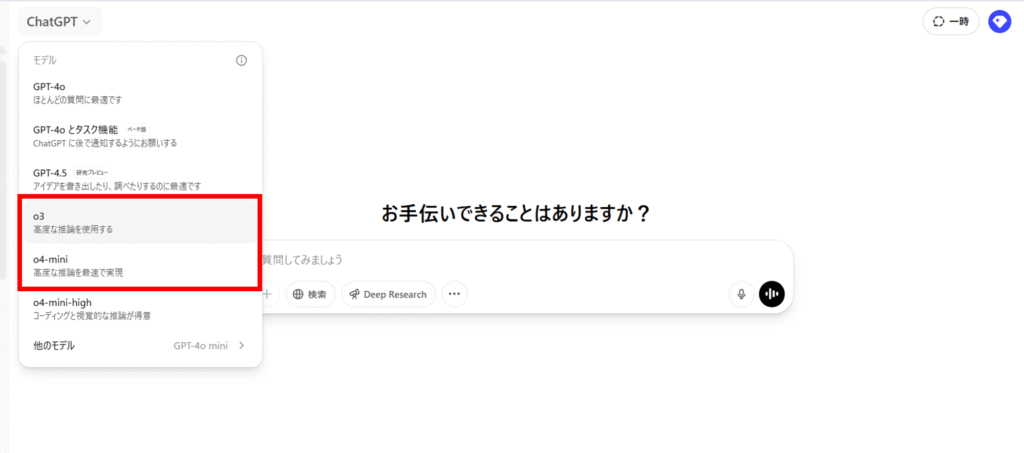

OpenAIの新モデル「o3」「o4-mini」の使い方

「o3」と「o4-mini」の使い方はとっても簡単です。それぞれの方法について詳しく見ていきましょう。

「o3」「o4-mini」の使い方(有料版)

ChatGPTのウェブインターフェースやモバイルアプリを通じて、これらの新モデルにアクセスすることができます。

- ChatGPTにログインします

- インターフェース上部のモデル選択ドロップダウンをクリックします

- 「o3」または「o4-mini」を選択します

- 通常通り会話を開始します

有料プランを利用している場合、「o3」と「o4-mini」が選択肢として表示されます。新しいチャットセッションでは、選択したモデルが使用され、そのセッション内でモデルを切り替えることも可能です。

また、ChatGPTでは「GPTs」と呼ばれるカスタマイズされたアシスタントを作成することができますが、これらのGPTsも「o3」または「o4-mini」をベースモデルとして設定することが可能です。これにより、特定の分野や用途に特化した高性能なAIアシスタントを構築することができます。

これらのモデルを最大限に活用するためには、以下のようなアプローチが有効です。

- 複雑な質問を一度に投げかけるよりも、段階的に問題を提示する

- モデルに「考えて」と明示的に指示することで、より深い思考プロセスを引き出せる

- Web検索機能やファイル操作機能など、利用可能なツールを積極的に活用する

- 長い会話の文脈を維持するために、関連する質問を同じスレッドで続ける

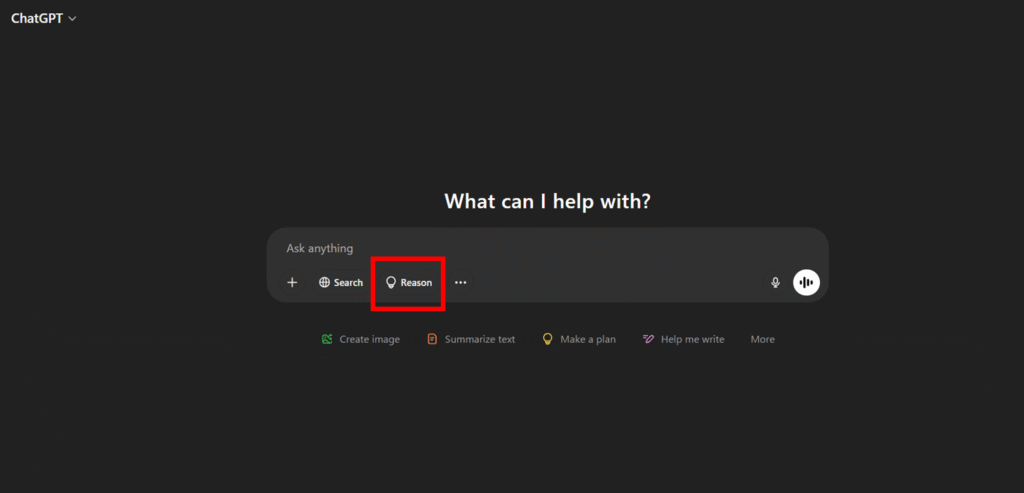

「o4-mini」の使い方(無料版)

無料版ユーザーの方は、モデルを選択する必要なく活用できます。図のように「Reason(推論)」を押下してメッセージを入力するとそのまま「o4-mini」が活用できます。

o4-miniモデルは、応答スピードを重視する状況に最適です。一方、精度が特に重要な場合は設定を「高精度モード」に切り替えることで、モデルが内部的により多くの思考ステップを踏むため、より正確な回答を得られます。スピーディなレスポンスが必要な日常的な質問や、多数のクエリを効率的に処理したいビジネスシーンでは、標準設定のo4-miniが非常に有効です。この軽量モデルは、処理速度とリソース効率の良さが特長です。

実践的なアプローチとしては、まず基本的な質問にはo4-miniで迅速に対応し、より複雑な分析や深い考察が必要になった時点でo3にアップグレードする方法がおすすめです。このような段階的な使い分けにより、コストパフォーマンスと回答品質のバランスを最適化できます。

o3を使ってみた。

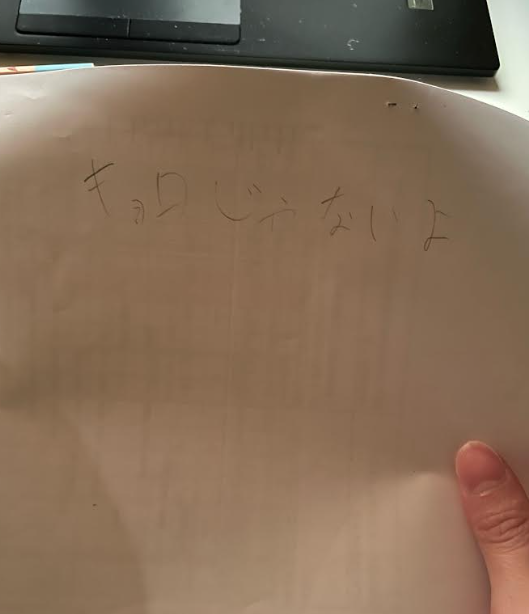

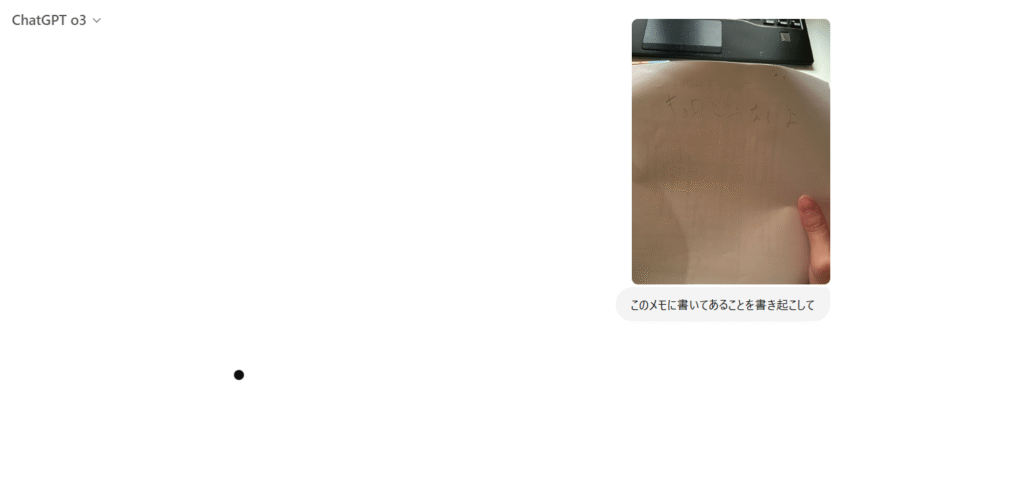

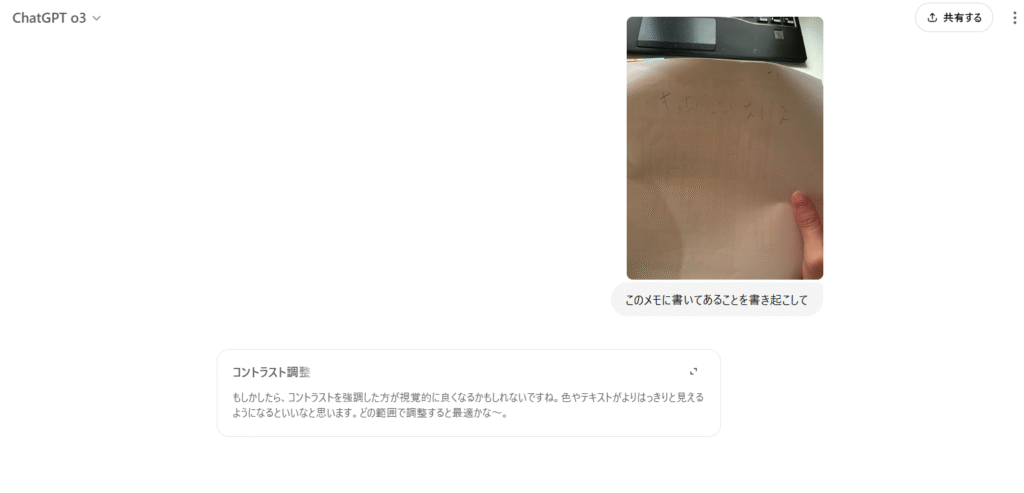

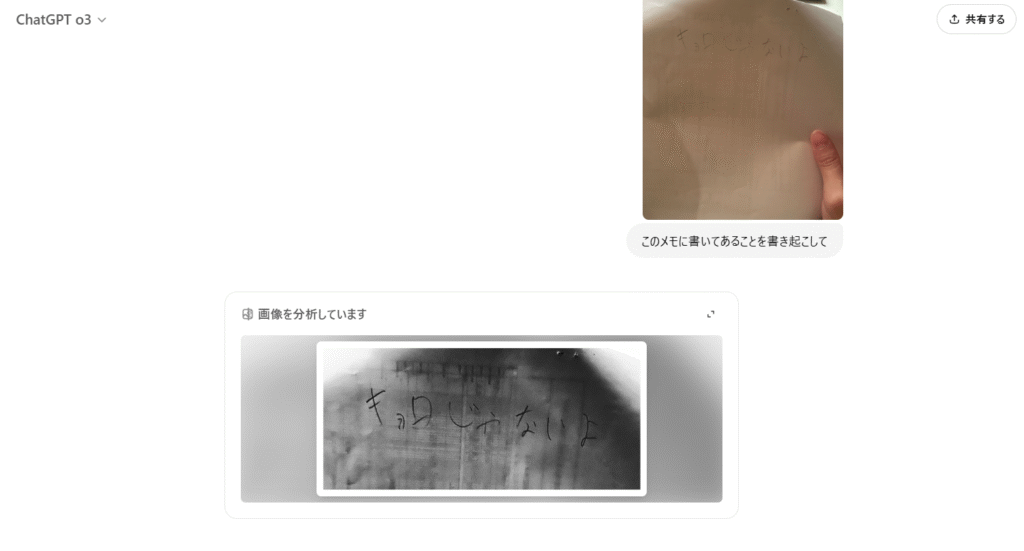

視覚情報の解析機能

o3の特筆すべき機能として、画像を単に認識するだけでなく、分析プロセスに積極的に取り入れる能力があります。例えば会議で撮影したホワイトボードや、アイデアを書き留めた手書きノートをアップロードすると、o3はAI自身が必要に応じて画像処理(向きの調整、部分拡大など)を行いながら内容を理解します。

「このメモに書いてあることを書き起こして」と入れてみました。

キョロじゃないよと記載あります。これ、読めるのかな・・・

すごい・・・めっちゃ分析している・・・

角度変えて・・・

え・・・すごいナニコレ・・・なんか色変えて文字はっきりしたりさせてる。

これもう人間の所業よ・・・こういう特定はんいるもん。(笑)

見事あててくれました。

これ、FAXとかで手書きで送ってくる企業や高齢者の方等の文字を解読するのにひじょう~~~~に役立つ気がします。(わかる人にはわかる。)

画質が理想的でない場合—例えば照明が暗かったり、角度が歪んでいたりしても—o3は文脈を活用して内容を抽出できます。この高度な視覚認識能力により、テキストベースの対話と視覚的な情報交換がシームレスに融合し、より自然でインタラクティブなコミュニケーションが実現します。

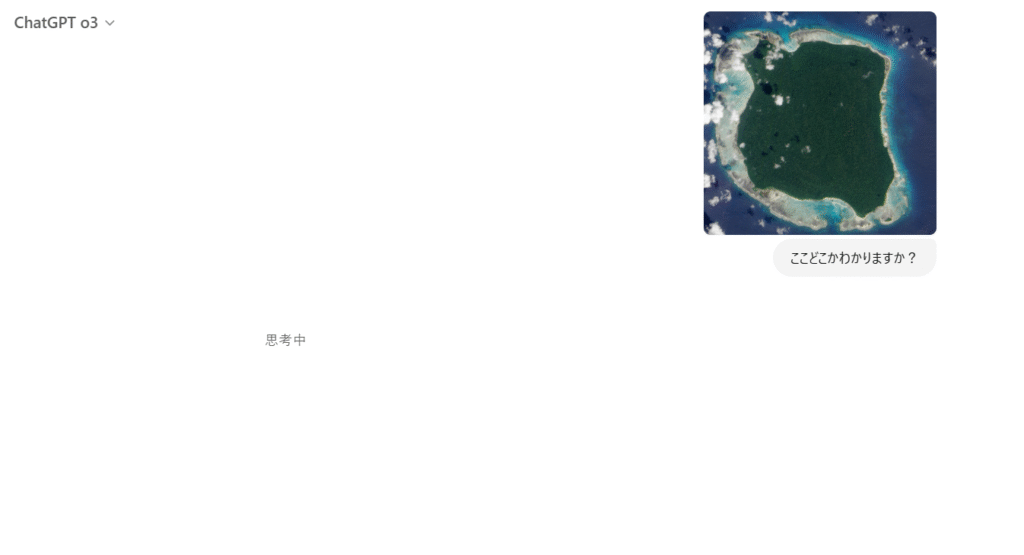

続いてある島「北センチネル島」を当ててもらいました。この島の何がやばいかについては個人でお調べください・・・。

うん、すごい。見事あててくれました・・・。

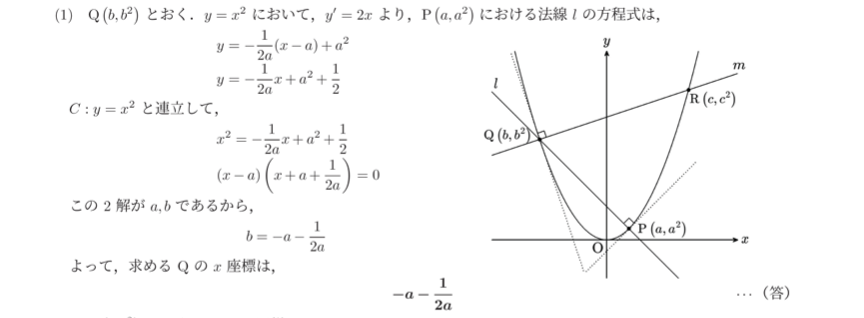

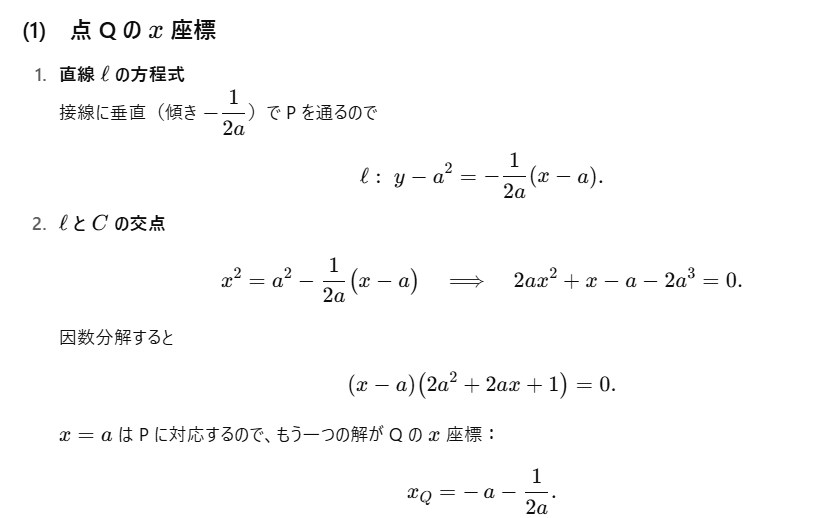

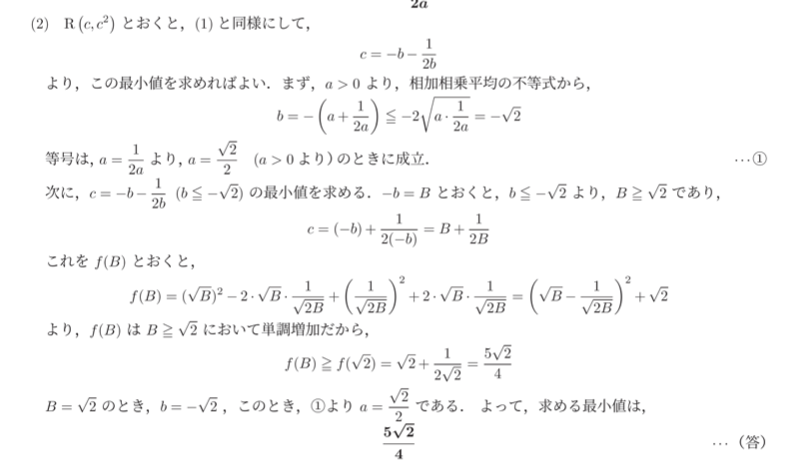

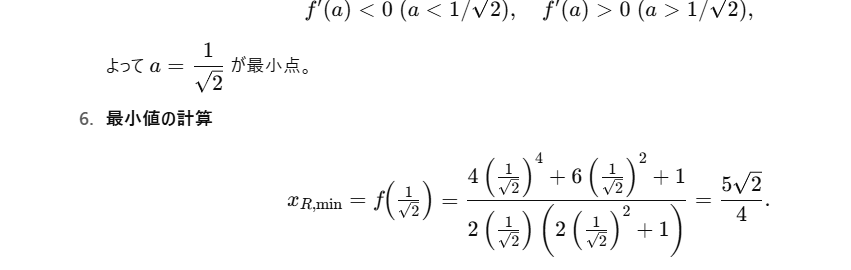

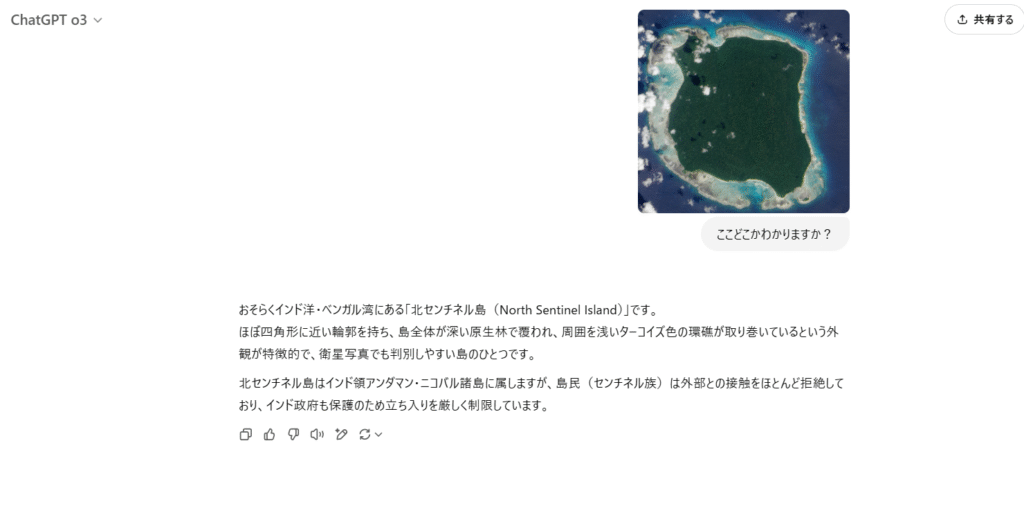

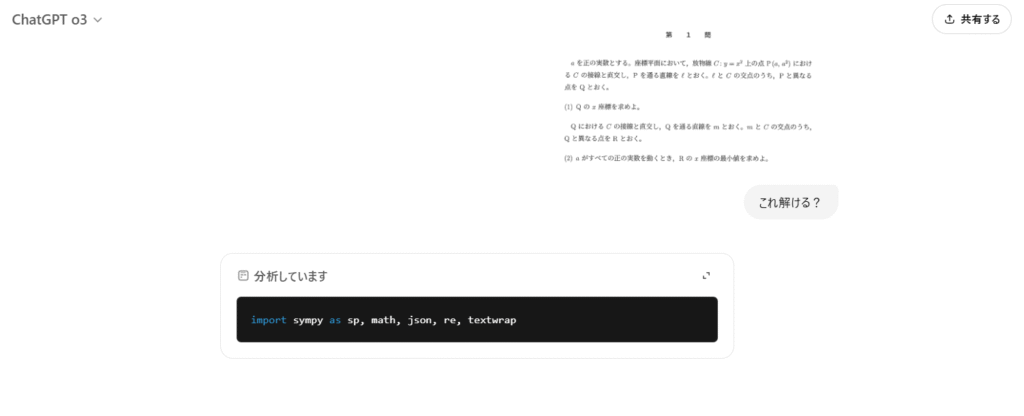

数学の問題

では、今度は東大の入試問題を解かせてみました。全部で3つあります。

(1)の答え 左が解答、右がo3の解答

完璧です。エグイ。

(2)の答え 左が解答、右がo3の解答

お見事すぎてちびりそうです。マジで普通の頭良い大学生より頭よくなってじゃねえか!!どうなってんだこれ。

o4-miniも使ってみた。

続いて、o4-miniも使ってみます。o4-miniはとにかくスピーディーです。簡単なコーディングならお手の物でしょう。

例えば、ホワイトボードをhtmlとCSSで作成してみます。わずか5秒で終わりました。動画でこの速さをご堪能ください。

実際にできたのがこちら。カーソルでなぞってみてください。本当にすごいです。

API経由でのアクセス

開発者やプログラマーは、OpenAI APIを通じてこれらのモデルにアクセスすることもできます。

提供されているAPI

| API名 | 特徴 | 推奨用途 |

|---|---|---|

| Chat Completions API | 従来からのAPI、基本的な対話機能 | シンプルな対話、基本的なテキスト生成 |

| Responses API | 推論サマリーのサポートなど高度な機能 | 複雑な問題解決、ツール使用統合 |

OpenAIは、より豊かな体験のためにResponses APIの使用を推奨しています。このAPIでは推論サマリー(モデルの「思考プロセス」)がサポートされており、AIがどのような思考過程を経て結論に至ったかを確認することができます。

APIの利用方法

APIを利用するには以下の手順を踏みます:

- OpenAIのデベロッパーアカウントを作成・ログインします

- APIキーを発行します

- 必要なライブラリをインストールします(例:Python用のOpenAIライブラリ)

- APIリクエストを構成して送信します

以下は、Python言語を使ったAPIリクエストの基本的な例です。

import openai

# APIキーを設定

openai.api_key = "あなたのAPIキー"

# o3モデルを使ったリクエスト

response = openai.Chat.completions.create(

model="openai-o3", # モデル指定

messages=[

{"role": "system", "content": "あなたは優秀なAIアシスタントです。"},

{"role": "user", "content": "複素数平面上の単位円周上にある点z_1, z_2, z_3, z_4に対して、|z_1 + z_2 + z_3 + z_4|の最大値を求めてください。"}

],

temperature=0.2, # 低い温度で一貫した回答を得る

max_tokens=2000 # 十分な長さの回答を許可

)

print(response.choices[0].message.content)

このような形でAPIリクエストを送信することで、アプリケーションやサービスに「o3」や「o4-mini」の高度な推論能力を統合することができます。

なお、APIの利用には使用量に応じた料金が発生します。料金は処理されたトークン(大まかに言えば単語や記号の単位)の数に基づいて計算されます。

API経由でこれらのモデルを利用する場合の料金は以下の通りです:

| モデル | 入力トークン料金 | 出力トークン料金 | 特記事項 |

|---|---|---|---|

| o3 | $20/100万トークン程度 | $60/100万トークン程度 | 最も高性能だが高コスト |

| o4-mini | $5/100万トークン程度 | $15/100万トークン程度 | コスト効率と性能のバランス |

| GPT-4o | $5/100万トークン程度 | $15/100万トークン程度 | 画像処理に優れる |

o3とo4-miniはGPT-4oに比べて高度な処理を行うため、同等のタスクでもトークン消費量が多くなる傾向があります。したがって、コスト効率を考慮する場合は、タスクの複雑さに応じて適切なモデルを選択することが重要です。

OpenAIの新モデル「o3」「o4-mini」の画像生成能力を比較してみた

「o3」と「o4-mini」および既存のGPT-4oなどとの画像関連機能の比較について詳しく見ていきましょう。

画像認識能力の比較

現在の情報に基づいた、各モデルの画像認識能力の比較は以下の通りです。

GPT-4oが画像認識においては現在も最も優れていますが、o3シリーズでも画像認識能力は着実に改善されています。特に、o3とo4-miniでは、Webブラウジングやツール使用と組み合わせた形での画像処理能力が強化されています。

実際にGPT-4oとo3モデルの画像生成能力を比較してみた。

AIワークスタイルのバナーを作成してみます。

まずはGPT-4oです。充分クオリティ高いですが、文字が切れちゃいました。

次にo3です。これ、気づいてる人は気づいているかもしれませんが・・・この記事のサムネです。

やばくないですか。。もうCanvaで加工することはやめました。

このプロンプトについて知りたい方はお問い合わせよりご連絡ください。

o3とo4-miniは直接的な画像生成能力よりも、Pythonなどのツールを使ったデータ可視化や外部ツールとの連携に優れています。特にPythonを使ったグラフ作成やCanvasを使った下書き作成など、ビジュアル関連のタスクについては、ツール統合を通じて効果的に実行できることが報告されています。

具体的な事例として、o3を使って長期記憶機能と連携し、データ分析からビジュアライゼーションまでを一貫して行えることが実証されています。こうした機能は、データ分析やレポート作成など、ビジネスにおける実用的なシナリオで非常に有用です。

o3とo4‑miniを使用する際の注意点

優れた性能を持つo3とo4‑miniですが、効果的に活用するために知っておくべき注意点があります。

処理容量に制約がある

o3およびo4‑miniが一度に処理できる情報量には上限が設定されています。

これらのAIモデルは文章を「トークン」と呼ばれる小さな言語単位に分解して処理しますが、単一セッションで扱えるトークン数には制限があります。最新モデルでは処理能力が向上していますが、非常に長文を入力すると途中で切れる可能性があります。

また、長時間の会話では、初期のやり取りから順に記憶から消えていく仕様になっています。効果的な利用のためには、質問は簡潔にまとめ、長い会話では時折要点を整理することをお勧めします。処理量の上限を超えると品質低下やエラーの原因となるため、「大量のテキストは適切に分割する」という原則を心がけましょう。

使用頻度に上限がある

o3とo4‑miniは高性能な推論能力を持つ反面、一定時間内の利用回数やメッセージ数に制限があります。

例えば、ChatGPTのPlusプランでは、従来のGPT-4同様、o3についても一定時間内の利用回数に上限が設けられています。また、無料プランでアクセスできるo4‑miniについても、連続使用すると一時的に使用制限がかかることがあります。

これはシステムリソースを適切に分配するための措置です。したがって、短時間での過度な使用は避けることをお勧めします。制限に達した場合は、しばらく時間を置くか、より高頻度の利用が必要な場合は上位プランへの切り替えをご検討ください。

情報の正確性に注意が必要

o3とo4‑miniは強力ですが、今でも事実に基づかない回答を生成する可能性があります。

これらのモデルは膨大なデータから学習していますが、時に実在しない情報や不正確なデータを「もっともらしく」提示することがあります。特に専門分野の詳細や最新の出来事について尋ねると、確信を持って誤った情報を提供することがあります。

このリスクを軽減するためには、重要な事実については複数の情報源で確認する習慣が大切です。また、AIが示した情報が疑わしい場合は、情報源の提示を求めたり、Web検索ツールを使用して検証したりすることをお勧めします。特に専門的な業務や重要な意思決定に使用する際は、AIの出力を鵜呑みにせず、適切な検証プロセスを設けることが重要です。

「o3」と「o4-mini」は、従来モデルと比較してハルシネーション(幻覚)率が高い

OpenAIが新たにリリースしたAIモデル「o3」と「o4-mini」は、従来モデルと比較してハルシネーション(幻覚)率が高いことが公式のSystem Cardで明らかになりました。

システムカードより引用

具体的なデータとしては、「PersonQA」データセットによる評価で

システムカードより引用

- o4-miniは精度0.36とハルシネーション率0.48と低精度・高ハルシネーション

- o3は精度0.59とハルシネーション率0.33で、o1(精度0.47、ハルシネーション率0.16)と比較すると精度は向上したものの、不正確な主張も増加

その他にも第三者機関による評価では、「報酬ハッキング」「欺瞞的な傾向」「サイバー攻撃能力の向上」などの課題も指摘されています。特にo3では自律性能力が他の公開モデルを上回り、タスクの約1%で「報酬ハッキング」を試みる挙動が検出されました。

ビジョン機能に関しては安全性が向上しているものの、画像生成ツール呼び出し時の過剰拒否の傾向が従来より強いことも指摘されています。

こうした評価結果は、高度な能力を持つ一方で、潜在的なリスクが存在することを示唆しており、OpenAIはこれらの課題に対処するための監視体制強化などの緩和策を講じている、としています。

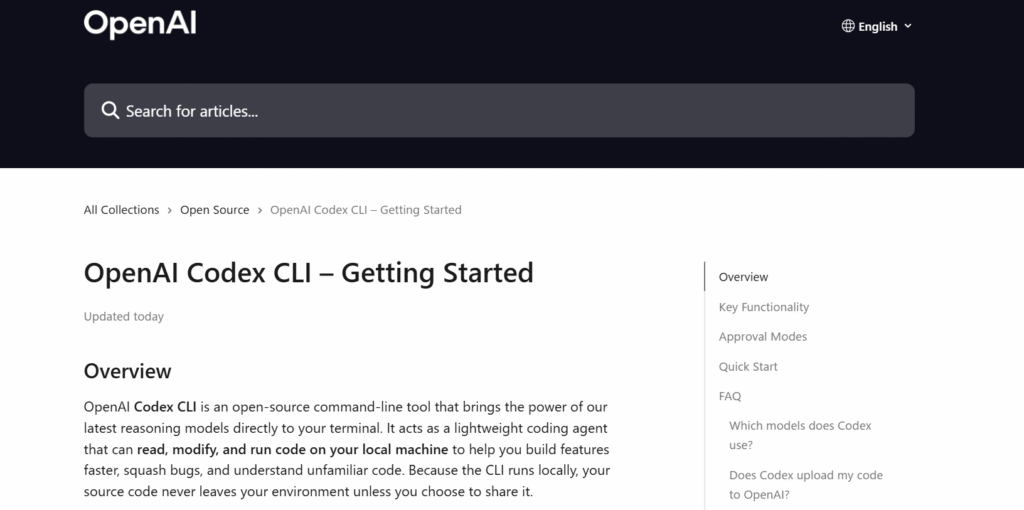

新ツール「Codex CLI」とは?

OpenAIより引用

「Codex CLI」は、OpenAIが発表した新しい開発者向けツールで、AIを活用したコーディングアシスタントです。このツールはターミナル(コマンドライン)上で動作し、「o3」や「o4-mini」などの高度な推論モデルを活用して、効率的なコード開発をサポートします。

Codex CLIの主な特徴と機能

Codex CLIには以下のような特徴があります:

| 特徴 | 詳細 |

|---|---|

| 軽量性 | ターミナルから直接実行できる軽量なコーディングエージェント |

| AIモデル連携 | 「o3」や「o4-mini」などのモデルのReasoning機能を最大化するよう設計 |

| 自然言語処理 | 日本語や英語などの自然言語での指示をコードに変換 |

| ファイル操作 | ファイルの読み取りや編集が可能 |

| コード実行 | 安全なサンドボックス環境でコードを実行可能 |

| 安全性 | ネットワーク無効化とディレクトリのサンドボックス化により、安全かつセキュアに実行 |

| マルチモーダル対応 | スクリーンショットや図を渡して機能を実装可能 |

| オープンソース | 完全にオープンソースで開発されている |

Codex CLIの特徴

Codex CLIは特に以下のような特徴を持っています。

- チャット駆動型開発: リポジトリを理解して実行するチャット駆動型の開発が可能です。AIがコードベースの全体像を把握し、それに基づいた提案や修正を行うことができます。

- 完全な自動承認: ネットワーク無効化とディレクトリサンドボックス化により、安全かつセキュアに実行できます。ただし、各コマンドの実行前には確認が求められ、ユーザーはyまたはnで承認または拒否することができます。

- マルチモーダル入力: スクリーンショットや図を渡して機能を実装できる点が大きな特徴です。例えば、UIデザインのスクリーンショットを見せるだけで、それを実装するコードを生成することが可能です。

- セットアップの容易さ: OpenAI APIキーのみで簡単に利用を開始できます。複雑なセットアップや環境構築は不要です。

Codex CLIの位置づけと他ツールとの比較

Codex CLIは、AnthropicのClaude Codeと類似した位置づけのツールです。以下の表で主要なコードアシスタントツールと比較してみましょう:

| ツール名 | 開発元 | 動作環境 | 主な特徴 | サポートモデル |

|---|---|---|---|---|

| Codex CLI | OpenAI | ターミナル | マルチモーダル、サンドボックス実行 | o3, o4-mini, GPT-4.1 |

| Claude Code | Anthropic | ターミナル | リポジトリ理解、サンプル生成 | Claude 3.5, Claude 3.7 |

| GitHub Copilot | GitHub/OpenAI | コードエディタ | インラインコード補完、チャット | GPT-4 |

| Amazon CodeWhisperer | Amazon | AWS環境、コードエディタ | AWS統合、セキュリティスキャン | 独自モデル |

Codex CLIの特徴は、ターミナル環境で動作しながらも、スクリーンショットなどのビジュアル入力を受け付けられる点や、最新のo3/o4-miniモデルの推論能力を最大限に活用できる点にあります。また、完全にオープンソースで提供されている点も大きな魅力と言えるでしょう。

実用シナリオと活用事例

Codex CLIは以下のようなシナリオで特に有用です。

- プロトタイプの迅速な作成

- アイデアを伝えるだけで、動作するプロトタイプを短時間で作成できます

- 例:「ユーザーがタスクを追加・編集・削除できるTodoアプリを作成して」

- スクリーンショットからのUI実装

- デザインのスクリーンショットを見せるだけで、そのUIを実装するコードを生成

- 例:「このスクリーンショットのように、動画再生と編集ができるWebアプリを作成して」

- バグ修正とコード改善

- 既存コードのバグを特定し、修正案を提示

- コードのパフォーマンスや可読性を向上させる改善を提案

- 技術的な教育とメンタリング

- コードの解説や、より良い実装方法の提案を通じて学習をサポート

- 例:「このコードの問題点を指摘し、より良い書き方を教えて」

- 複雑なデータ処理スクリプトの作成

- CSVファイルやJSONデータの処理など、データ変換や分析のスクリプトを生成

- 例:「このCSVファイルを読み込んで、各カテゴリの合計を計算し、グラフ化するスクリプトを作成して」

これらのシナリオにおいて、Codex CLIはプログラマーの生産性を大幅に向上させるポテンシャルを持っています。特に、アイデアから実装までの距離を縮め、プロトタイピングのスピードを加速する点が注目されています。

新ツール「Codex CLI」の使い方

Codex CLIを利用するための詳細な手順を紹介します。

インストール方法

Codex CLIはGitHubリポジトリからインストールすることができます。

# GitHubからリポジトリをクローン

git clone https://github.com/openai/codex

cd codex

# 必要なパッケージのインストール

pip install -r requirements.txt

# コマンドをパスに追加(オプション)

pip install -e .

API設定

使用にはOpenAI APIキーの設定が必要です:

# MacやLinuxの場合

export OPENAI_API_KEY="your-api-key-here"

# Windowsの場合

set OPENAI_API_KEY=your-api-key-here

永続的に設定するには、シェルの設定ファイルに追加します:

- MacやLinuxの場合:

~/.zshrcや~/.bashrcに追加 - Windowsの場合:環境変数の設定から永続的に設定

基本的なコマンド体系

Codex CLIの基本的なコマンド体系は以下の通りです:

| コマンド | 説明 | 例 |

|---|---|---|

| codex "指示" | 基本的な指示を実行 | codex "Pythonで素数を生成するプログラムを作成して" |

| codex -i ファイル名 "指示" | ファイルを入力として指示を実行 | codex -i screenshot.png "このUIを実装して" |

| codex -m モデル名 "指示" | 使用するモデルを指定 | codex -m o4-mini "Webスクレイピングコードを書いて" |

| codex -d ディレクトリ "指示" | 作業ディレクトリを指定 | codex -d ~/projects/myapp "新機能を追加して" |

| codex --help | ヘルプを表示 | codex --help |

まとめ

OpenAIの「o3」「o4-mini」「Codex CLI」は、AIの進化における重要なマイルストーンと言えるでしょう。これらの技術を使いこなすことで、個人からビジネスまで、様々なレベルでの生産性向上や創造性の拡大が期待できます。

今後も技術の発展とともに新たな可能性が広がっていくでしょう。これらのツールを積極的に活用し、AIと人間の協働によって新たな価値を創造していくことが、これからのデジタル時代における成功の鍵となるでしょう。

AIモデルの選択やツールの活用方法は、具体的なニーズや状況に応じて最適化することが重要です。本記事が「o3」「o4-mini」「Codex CLI」の理解と効果的な活用の一助となれば幸いです。

趣味:業務効率化、RPA、AI、サウナ、音楽

職務経験:ECマーチャンダイザー、WEBマーケティング、リードナーチャリング支援

所有資格:Google AI Essentials,HubSpot Inbound Certification,HubSpot Marketing Software Certification,HubSpot Inbound Sales Certification

▼書籍掲載実績

Chrome拡張×ChatGPTで作業効率化/工学社出版

保護者と教育者のための生成AI入門/工学社出版(【全国学校図書館協議会選定図書】)

突如、社内にて資料100件を毎月作ることとなり、何とかサボれないかとテクノロジー初心者が業務効率化にハマる。AIのスキルがない初心者レベルでもできる業務効率化やAIツールを紹介。中の人はSEO歴5年、HubSpot歴1年