人工知能企業OpenAIは、年次開発者向けイベント「DevDay」の形式を大幅に変更すると発表しました。この決定は、AI業界の急速な変化と、OpenAIが直面する課題を反映しているようです。

本記事ではOpenAI DevDay 2024で発表された内容をまとめたものを紹介していきます。

OpenAI DevDay 2023の記事は以下をご覧ください。

所有資格:Google AI Essentials

所有資格:Google AI Essentials

- OpenAIが開発者向けに5つの新機能を発表:

- リアルタイムAPI:音声入出力の即時処理を実現

- プロンプトキャッシュ:応答速度向上とコスト削減

- モデル蒸留:小規模モデルの性能を大幅に向上

- 画像対応のファインチューニング:視覚的タスクの精度を改善

- 新Playground機能:より直感的なモデル調整を可能に

イベント形式の変更

OpenAIより引用

2023年に華々しく開催されたDevDayとは対照的に、2024年のイベントはより控えめな形式で行われます。昨年のような大規模な記者会見ではなく、今年は世界各地で一連の開発者エンゲージメントセッションを開催する予定です。

特にYoutubeなどでのアーカイブはございません。残念・・・。

具体的には以下の日程で開催されます

- サンフランシスコ:10月1日

- ロンドン:10月30日

- シンガポール:11月21日

各イベントでは、ワークショップ、ブレイクアウトセッション、OpenAIの製品・エンジニアリングスタッフによるデモ、開発者スポットライトなどが予定されています。

参加費は450ドルですが、条件を満たす参加者向けに奨学金制度も用意されています。参加申し込みの締め切りは8月15日とのことです。

OpenAIが開発者向けに発表した新機能は5つ!

OpenAIは2024年10月1日に開催されたDevDayで、AI開発の未来を大きく変える5つの新機能を発表しました。これらの機能は、開発者がより高度で効率的なAIアプリケーションを構築するための新たな可能性を開きます。

・リアルタイムAPI:音声入出力の即時処理を実現

・プロンプトキャッシュ:応答速度向上とコスト削減

・モデル蒸留:小規模モデルの性能を大幅に向上

・画像対応のファインチューニング:視覚的タスクの精度を改善

・新Playground機能:より直感的なモデル調整を可能に

1.Realtime API

OpenAIは、開発者がアプリケーションに低遅延のマルチモーダル体験を組み込むことを可能にする、Realtime APIのパブリックベータ版を発表しました。この新しいAPIは、ChatGPTの高度な音声モードに似た機能を提供し、AIとの自然な音声対話を実現します

Realtime APIの主な機能は以下の通り。

- 低遅延の音声対話:

- GPT-4oモデルを使用した、リアルタイムに近い音声会話機能

- 6つのプリセット音声をサポート

- マルチモーダル入出力:

- テキストまたは音声入力に対応

- テキスト、音声、または両方での応答が可能

- シームレスな統合:

- 単一のAPI呼び出しで完結する自然な会話体験

- 複数のモデルを組み合わせる必要性を排除

- 感情と強調の保持:

- 従来の方法で失われがちだった感情、強調、アクセントを維持

- 機能呼び出し(Function Calling)対応:

- 音声アシスタントがユーザーの要求に応じてアクションを起こすことが可能

先日発表されたAdvanced Voice modeに近い機能ですね。これがAPIで使えるのであれば世界はかなり変わっていくでしょう。

OpenAIより引用

| カテゴリ | 詳細 |

|---|---|

| 技術的詳細 |

|

| 価格設定 |

|

| 安全性とプライバシー |

|

| 利用開始方法 |

|

Realtime APIの応用例

今後の応用例としては以下が想定できます

- Healthify:栄養とフィットネスコーチングアプリ

- AIコーチRiaとの自然な会話を実現

- 必要に応じて人間の栄養士が介入可能

- Speak:言語学習アプリ

- ロールプレイ機能で新しい言語の会話練習をサポート

実際に以下はRealtime APIを用いて言語学習をアプリでしている様子です。これ、もうAIでいいやってなりますよね。

OpenAIより引用

2.API用プロンプトキャッシュ

OpenAIは、開発者向けに新たな機能「プロンプトキャッシュ」を導入しました。この機能は、AIアプリケーション開発におけるコスト削減と応答速度の向上を実現します。

プロンプトキャッシュの主要ポイント

- 最近使用されたインプットトークンを再利用し、50%のコスト削減を実現

- 処理速度の向上によるレイテンシの削減

- GPT-4o、GPT-4o mini、o1-preview、o1-miniの最新バージョンで自動的に適用

- 1,024トークン以上のプロンプトに対して有効

開発者にとってのメリット

- コスト削減: 頻繁に使用されるプロンプトの入力コストを半減

- 応答速度の向上: キャッシュされたトークンの処理が高速化され、全体的なレイテンシを削減

- シームレスな統合: API統合の変更なしに自動的に適用されるため、開発者の負担が少ない

- 柔軟性: 様々なモデルとそのファインチューニングバージョンに対応

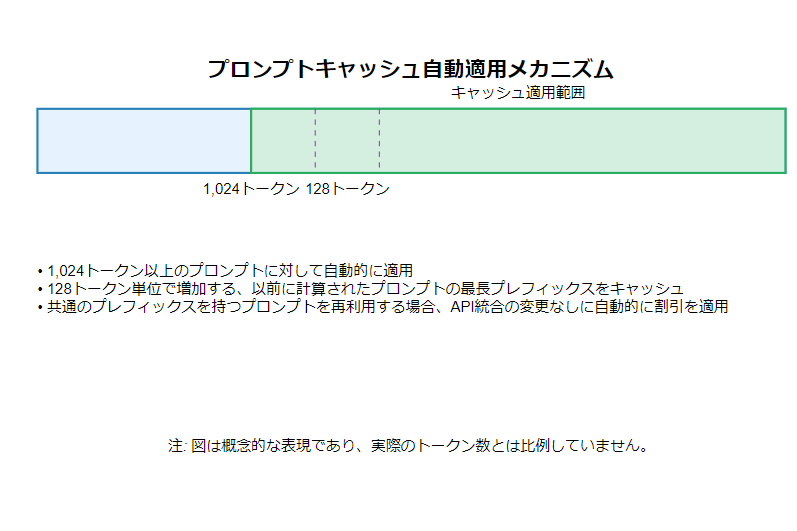

自動適用のメカニズム

- 1,024トークン以上のプロンプトに対して自動的に適用

- 128トークン単位で増加する、以前に計算されたプロンプトの最長プレフィックスをキャッシュ

- 共通のプレフィックスを持つプロンプトを再利用する場合、API統合の変更なしに自動的に割引を適用

対応モデルと価格設定

| モデル | 非キャッシュ入力トークン | キャッシュ入力トークン | 出力トークン |

|---|---|---|---|

| GPT-4o (gpt-4o-2024-08-06) | $2.50 | $1.25 | $10.00 |

| GPT-4o ファインチューニング | $3.75 | $1.875 | $15.00 |

| GPT-4o mini (gpt-4o-mini-2024-07-18) | $0.15 | $0.075 | $0.60 |

| GPT-4o mini ファインチューニング | $0.30 | $0.15 | $1.20 |

| o1-preview | $15.00 | $7.50 | $60.00 |

| o1 mini | $3.00 | $1.50 | $12.00 |

キャッシュ使用状況のモニタリング

- APIレスポンスの

usageフィールド内にcached_tokens値が含まれる - 例:

json

usage: {

total_tokens: 2306,

prompt_tokens: 2006,

completion_tokens: 300,

prompt_tokens_details: {

cached_tokens: 1920,

audio_tokens: 0,

},

completion_tokens_details: {

reasoning_tokens: 0,

audio_tokens: 0,

}

}

キャッシュの有効期限

- 非アクティブ状態が5-10分続くとクリア

- 最後の使用から1時間以内に必ず削除

安全性とプライバシー

- エンタープライズプライバシーコミットメントの対象

- プロンプトキャッシュは組織間で共有されない

3.モデル蒸留:小規模モデルの性能を大幅に向上

OpenAIは、開発者向けに新たな「モデル蒸留」機能を導入しました。この革新的な機能により、開発者はOpenAIプラットフォーム上で高性能なフロンティアモデルの知識を、より効率的な小規模モデルに転移させることが可能になりました。

モデル蒸留とは

モデル蒸留は、大規模で高性能なAIモデル(教師モデル)の出力を使用して、より小規模で効率的なモデル(生徒モデル)を訓練する技術です。この手法により、特定のタスクにおいて、小規模モデルが大規模モデルに匹敵する性能を発揮しつつ、より低いコストで運用することが可能になります。

開発者にとってのメリット

- コスト効率の向上: 高性能モデルの能力を低コストで実現

- カスタマイズの容易さ: 特定のタスクに特化したモデルを効率的に作成

- 統合されたワークフロー: データセット作成からモデル評価まで一貫したプロセス

- 迅速な開発サイクル: 継続的な評価と改善が容易

- リソース最適化: 小規模モデルの使用によるインフラストラクチャコストの削減

OpenAIのモデル蒸留スイート

OpenAIは、モデル蒸留のプロセス全体を管理するための統合ワークフローを提供します。このスイートには以下の機能が含まれます:

- Stored Completions(保存された完了)

- API経由でGPT-4oやo1-previewなどのモデルが生成した入出力ペアを自動的に捕捉・保存

- 本番データを使用してデータセットを構築し、モデルの評価やファインチューニングに利用可能

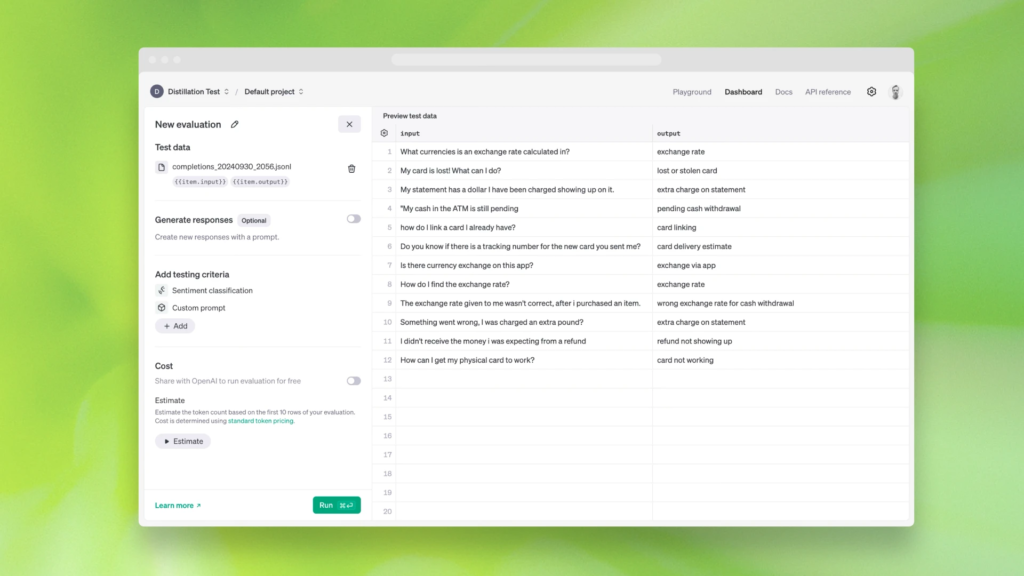

- Evals(評価)(ベータ版)

- カスタム評価をプラットフォーム上で作成・実行し、特定のタスクにおけるモデルのパフォーマンスを測定

- Stored Completionsのデータや既存のデータセットを使用して評価を設定可能

- Fine-tuning(ファインチューニング)

- Stored CompletionsとEvalsを既存のファインチューニング機能と完全に統合

- プラットフォーム内でデータセットの作成からモデルの評価まで一貫して実行可能

モデル蒸留の使用方法

評価の作成

OpenAIより引用

蒸留先のモデル(例:GPT-4o mini)のパフォーマンスを測定するための評価を作成

この評価を使用して、蒸留モデルの継続的なパフォーマンステストを実施

蒸留データセットの作成

response = client.chat.completions.create(

model=”gpt-4o”,

messages=[

{

“role”: “user”,

“content”: [

{

“type”: “text”,

“text”: “what’s the capital of the USA?”

}

]

}

],

store=True,

metadata={“username”: “user123”, “user_id”: “123”, “session_id”: “123”}

- Stored Completionsを使用して、GPT-4oの出力から実世界の例を含むデータセットを作成

- Chat Completions APIで’store:true’フラグを設定し、入出力ペアを自動的に保存

ファインチューニングの実行

- 作成したデータセットを使用してGPT-4o miniをファインチューニング

- Evalsを使用して、ファインチューニングされたモデルがパフォーマンス基準を満たしているか確認

反復的な改善

- 結果が満足できない場合、データセットの精緻化、トレーニングパラメータの調整、または特定の例の追加を実施

- 本番利用に十分な性能が得られるまで、プロセスを繰り返す

利用可能性と価格設定

- すべての開発者が利用可能

- GPT-4oやo1-previewを含む全モデルで蒸留可能

- 2024年10月31日まで、GPT-4o miniで1日200万トークン、GPT-4oで1日100万トークンの無料トレーニングを提供

- 標準のファインチューニング価格が適用(APIの価格ページで確認可能)

- Stored Completionsは無料で利用可能

- Evalsはベータ版で、使用したトークンに基づいて標準モデル価格で課金

- 2024年末まで、OpenAIとEvalsを共有することに同意した開発者は週7回まで無料で評価を実行可能

実践的な応用例

- カスタマーサポート: 特定の製品や サービスに関する質問に特化した効率的なチャットボットの開発

- コード生成: 特定のプログラミング言語や開発フレームワークに特化したコード補完モデルの作成

- データ分析: 特定の業界や分野のデータ分析タスクに最適化されたモデルの開発

- 多言語翻訳: 特定の言語ペアや専門分野に特化した高性能な翻訳モデルの構築

OpenAIのモデル蒸留機能は、高性能AIモデルの能力をより広範囲の開発者や企業が利用できるようにする重要な一歩です。この技術により、AIの民主化が促進され、より多くの革新的なアプリケーションが生まれることが期待されます。開発者は、この機能を活用することで、高度なAI能力を効率的かつ経済的に自社のプロダクトに組み込むことが可能になります。

4.画像対応のファインチューニング:視覚的タスクの精度を改善

OpenAIは、GPT-4oモデルに画像を用いたファインチューニング機能を追加したことを発表しました。この革新的な機能により、開発者はテキストだけでなく画像データを使用してモデルをカスタマイズし、特定の視覚タスクにおける性能を大幅に向上させることが可能になりました。

主要ポイントは以下の通り

・最小100枚の画像でモデルの視覚能力を向上

・2024年10月31日まで、1日1Mトークンまで無料で利用可能

・最新の「gpt-4o-2024-08-06」モデルで利用可能

画像ファインチューニングの仕組み

- テキストによるファインチューニングと同様のプロセスを採用

- 開発者は適切なフォーマットで画像データセットを準備し、プラットフォームにアップロード

- 少量のデータ(100枚の画像)でも効果を発揮し、より多くのテキストと画像データで更なる性能向上が可能

実際の使用事例

1. Grab(配車・配送サービス)

OpenAIより引用

- 交通標識の位置特定と車線区分線のカウントを改善

- わずか100例のトレーニングで、車線数の精度を20%、速度制限標識の位置特定を13%向上

2. Automat(企業向け自動化ソリューション)

OpenAIより引用

- 画面上のUI要素を自然言語で特定する能力を強化

- RPAエージェントの成功率を16.60%から61.67%に向上(272%の性能向上)

- 200枚の非構造化保険文書画像で情報抽出タスクのF1スコアを7%向上

GPT-4oの画像ファインチューニング機能は、AIの視覚理解能力を新たな次元に引き上げる可能性を秘めています。この機能により、開発者はより精密で効果的な視覚AIアプリケーションを構築することが可能になり、様々な産業分野でのAI活用が一層加速することが期待されます。

5.新Playground機能:より直感的なモデル調整を可能に

OpenAIは、開発者がAIモデルを使用したアイデアを素早くプロトタイプ化できる新しいPlayground機能を発表しました。この革新的な機能は、システムプロンプトの自動生成を通じて、AI開発プロセスを大幅に簡素化し、効率化します。

主要機能

- システムプロンプトの自動生成

- ユーザーはモデルの使用目的を簡単に記述するだけで、AIが適切なシステムプロンプトを自動生成

- 複雑なプロンプトエンジニアリングの必要性を軽減

- スキーマの自動生成

- 関数や構造化された出力に対する有効なJSONスキーマを自動的に生成

- 開発者は詳細なスキーマ定義に時間を費やすことなく、アイデアの実装に集中可能

- Playgroundでの即時利用

- http://playground.openai.com で直接利用可能

- ウェブブラウザ上で迅速にアイデアをテストし、結果を確認

新Playground機能のメリット

・開発時間の短縮

プロンプトの作成とスキーマ定義に要する時間を大幅に削減

アイデアから実装までのサイクルを加速

・アクセシビリティの向上

プロンプトエンジニアリングの経験が少ない開発者でも高度な機能を利用可能

AIモデルの活用範囲を拡大

・品質の向上

AIによって生成されたプロンプトとスキーマにより、一貫性と品質を確保

ベストプラクティスに基づいた設定を自動的に適用

Youtuberヒカキンと日清のカップ麺のコラボレーションの台本アイデアを考えてください。と打ってみました。以下は実際の動画です。GPT-4ominiであれば無料で使えますので是非、試してみてください。

Youtuberヒカキンと日清のカップ麺のコラボレーションの台本アイデアを考えてください。 次の要素を含むアイデアを作成してください: - ヒカキンと日清のカップ麺の特徴 - ユーモアとヒカキンのキャラクター性 - 製品の魅力とユニークポイント # Steps 1. **イントロダクション**: - ヒカキンが視聴者にあいさつし、コラボレーションの背景を簡単に紹介する。 - ヒカキンの特徴的なオープニングフレーズやジェスチャーを使用する。 2. **製品の紹介**: - 日清のカップ麺の特徴、風味、ユニークポイントを紹介する。 - ヒカキンが製品を試食し、リアクションを伝える。 - 製品の開発経緯や特別な成分について言及する。 3. **ユーモラスな要素**: - 試食中に面白いリアクションやコメントを挿入。 - 視聴者への笑いを誘うエピソードや小ネタを挿入。 4. **実演とアクティビティ**: - コラボ製品を使った料理やアレンジレシピの実演。 - 他の関連製品との比較やランキングを行うセグメント。 5. **クロージング**: - 視聴者へのメッセージ、コラボ製品の購入案内。 - 次回の動画の予告や視聴者への感謝の言葉。 # Output Format 台本アイデアは、箇条書きの形式で各ステップを明示し1〜2段落の具体的な内容を提供してください。 # Examples **Example 1:** 1. **イントロダクション**: - ヒカキンが「どうもー!ヒカキンです!」と元気にあいさつ。 - 日清と特別なコラボをしてカップ麺を紹介することを伝える。 2. **製品の紹介**: - 「今回紹介するのはこちら、日清の新しいカップ麺です!」と商品をカメラに見せる。 - 「このカップ麺、特別なスパイスが入ってるんです!」と製品の特徴を説明。 - 実際にカップ麺を開けて、お湯を入れるところを見せる。 3. **ユーモラスな要素**: - カップ麺ができるのを待つ間、ヒカキンが面白い顔をしたり、ダンスをする。 - 食べる前に「おいしくなーれ!」と言いながらカップ麺に手を振るリアクション。 4. **実演とアクティビティ**: - ヒカキンが作ったカップ麺を味見し、「うまい!」と感激の声を上げる。 - 「この味、他にはない!もう一回!」とおかわりするジェスチャー。 5. **クロージング**: - 「ぜひ皆さんもこのカップ麺、試してみてください!」と視聴者に呼びかけ。 - 次回の動画の予告をし、「チャンネル登録と高評価よろしくね!」と締めくくる。 **Example 2:** 1. **イントロダクション**: - ヒカキンが「こんにちは、みなさん!」と明るく登場。 - 日清とのコラボについて簡単に背景を説明。 2. **製品の紹介**: - コラボカップ麺のパッケージデザインを紹介。 - 食べる前にカップ麺の成分や特長を一つ一つ詳しく説明。 3. **ユーモラスな要素**: - 作る間にヒカキンらしいユーモア溢れるコメントを挟む。 - 試食中に「これ、美味しすぎて笑っちゃうよ!」と笑いを取る。 4. **実演とアクティビティ**: - カップ麺を使った簡単アレンジレシピを紹介。 - 「みんなもこのレシピ試してみてね!」と視聴者に挑戦を促す。 5. **クロージング**: - 「最後まで見てくれてありがとう!」のあと、視聴者に感謝。 - 次回の動画を簡単に予告し、「それではまた次の動画で!」と言って笑顔で終了。 # Notes - **ヒカキンのキャラクターを活かす**: ヒカキンのテンションの高いキャラクター性を出すことが重要。 - **注目点を明確に**: 商品のユニークな売りを強調する部分を明確にする。 - **視聴者参加型の要素**: 視聴者が参加できる企画(コメント募集やアンケートなど)を考慮する。

使用例

- 感情分析ツール

- 目的:「ソーシャルメディアの投稿から感情を分析し、ポジティブ/ネガティブ/中立のスコアを出力する」

- 自動生成されたプロンプトとスキーマにより、感情分析機能を迅速に実装

- 商品推薦システム

- 目的:「ユーザーの購買履歴に基づいて、5つの商品を推薦する」

- システムが適切なプロンプトと構造化出力のスキーマを生成し、推薦ロジックを簡単に実装

- コードレビューアシスタント

- 目的:「Pythonコードを分析し、改善点と最適化提案を提供する」

- 自動生成されたプロンプトにより、コードレビューの基準とフィードバックの構造を定義

OpenAIの新しいPlayground機能は、AI開発のプロトタイピングプロセスを革新的に変えるポテンシャルを秘めています。システムプロンプトとスキーマの自動生成により、開発者はアイデアの実装に

より多くの時間を費やすことができ、イノベーションのスピードを加速させることが可能になります。

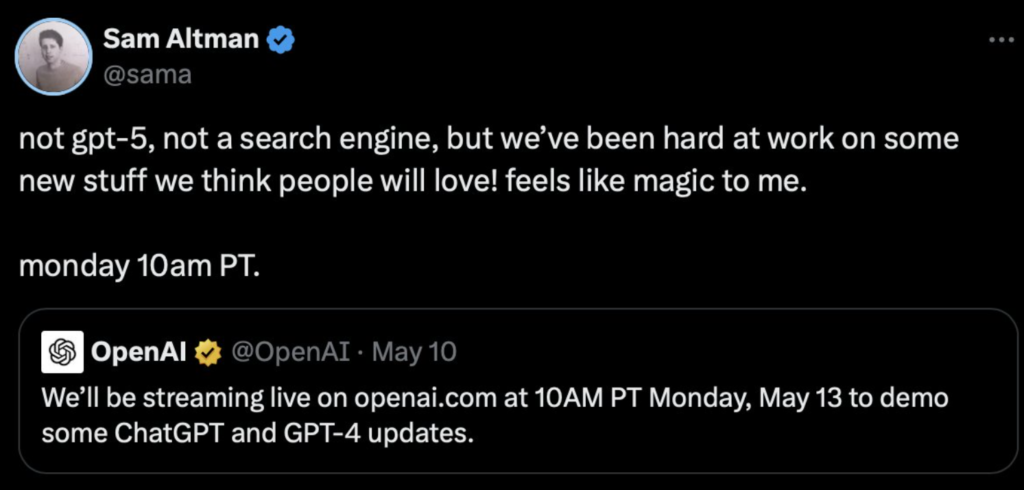

新モデル発表の見送り

注目すべきは、OpenAIが次期主力モデルの発表をDevDayで行わないことをサムアルトマンが明言した点です。OpenAIの広報担当者は「DevDayで次のモデルを発表する予定はありません」と述べ、代わりに「利用可能なものについて開発者を教育し、開発者コミュニティの事例を紹介することに重点を置く」としています。

これは、GPT-4やGPT-4 miniの後継モデルとなる「GPT-5」の発表を期待していた多くの観察者にとって驚きとなるでしょう。

実際に最近o1 previewの発表をしたばかりなのでやむを得ないところです。。

まとめ

OpenAI DevDay 2024の形式変更は、AI業界の急速な変化と、OpenAIが直面する様々な課題を反映しています。高品質なデータの確保、著作権問題、競合他社との技術競争、そして安全性への懸念など、OpenAIは多くの課題に直面しています。

今後のDevDayでは、革新的な新製品の発表よりも、既存のAPIや開発者サービスの更新、そして開発者コミュニティとのより密接な関係構築に焦点が当てられそうです。これは、OpenAIが長期的な成長と持続可能性を重視する方向にシフトしていることを示唆しているのかもしれません。

AI業界の関係者や開発者たちは、今後のOpenAIの動向を注意深く見守ることになるでしょう。DevDay 2024は、OpenAIの新たな方向性を示す重要な指標となるかもしれません。

趣味:業務効率化、RPA、AI、サウナ、音楽

職務経験:ECマーチャンダイザー、WEBマーケティング、リードナーチャリング支援

所有資格:Google AI Essentials,HubSpot Inbound Certification,HubSpot Marketing Software Certification,HubSpot Inbound Sales Certification

▼書籍掲載実績

Chrome拡張×ChatGPTで作業効率化/工学社出版

保護者と教育者のための生成AI入門/工学社出版(【全国学校図書館協議会選定図書】)

突如、社内にて資料100件を毎月作ることとなり、何とかサボれないかとテクノロジー初心者が業務効率化にハマる。AIのスキルがない初心者レベルでもできる業務効率化やAIツールを紹介。中の人はSEO歴5年、HubSpot歴1年