OpenAIより引用

「ChatGPT」の開発元OpenAIは、アメリカ西海岸時間の2023年11月6日(日本時間で深夜3:00)にサンフランシスコで開発者向けカンファレンス「OpenAI DevDay」を開催されました。OpenAI DevDayは開発者が新しいアイデアを共有し、OpenAIの最新ツールや技術に触れる貴重な機会を提供するものです。

現地で参加する開発者は、OpenAIの専門技術スタッフが司会を務めるさまざまな分科会セッションに参加することができます。

DevDayは主に対面での参加はもちろん、基調講演はオンラインでライブストリームされるため、遠隔地にいる開発者も参加可能となった今回の初公演。

大変盛り上がったみたいです。

OpenAI DevDayについての実際の盛り上がりや内容は上記動画から参照いただけます。

この記事ではそんな中でどんな発表があったのか、ChatGPTの新技術に焦点をあてつつ、

レポートをまとめさせていただきます。

この記事はこんな人におすすめ

・OpenAI DevDayで発表されたChatGPTの新機能の概要が知りたい

・OpenAI DevDayがどんな感じものだったのか知りたい

OpenAI DevDayで発表された5つの要点

まずはざっくりとOpenAI DevDayでの発表であった5つの要点を共有します。

時間のない方は下記5つだけでも頭の隅に入れておき、またこの記事に戻ってきてください。

- OpenAIはサンフランシスコで初のDev Dayを開催し、1年前のChat GPTの出荷や最近のGPT-4のローンチ、音声や視覚機能を持つ能力など、いくつかの新機能とアップデートを発表しました。

- GPT-4 Turboを導入し、これまでの8,000トークンから大幅に増やした128,000トークンのコンテキストをサポートし、2023年4月までの最新の知識を更新しました。

- Whisper V3オープンソース音声認識モデルの新開発や、AIが声を通じてより自然に相互作用できるようにするなどの進歩が強調されました。

- GPT-4 Turboの使用コストを下げることを発表し、開発者へのアクセシビリティを向上させるとともに、特定の目的のためにカスタマイズされたChat GPTバージョンであるGPTの概念を紹介しました。

- マイクロソフトとのパートナーシップを発表し、開発者に強力なシステムと計算リソースを提供することに焦点を当て、Chat GPTのモデルピッカーの改善と、AI駆動のアプリケーションを構築するための新しい開発者ツールを紹介しました。

OpenAI DevDayで発表されたChatGPT総まとめ(簡潔版)

AI研究開発のリーダーであるOpenAIは、2023年11月6日に初のDevDayをサンフランシスコで開催されました。この一日限りの会議は、世界中のAI開発の最先端を行く人々が集まったそうです。

OpenAI DevDayで最も注目されたのは、GPT APIの大幅な改善と新しいAPIの追加でした。GPT APIとは、OpenAIが提供する自然言語処理のAPIで、GPT-4という強力なモデルを使って、様々なタスクを実現できます。GPT APIは、以下のように全般的に改善されました。

忙しい方はこの章だけ見て、また戻ってきてください!ブクマを推奨します!

・ChatGPTの新モデルGPT-4 Turboの発表、APIが総まとめで公開!!

1.送信できる文章の長さが12万8千トークンに拡大!!

2.コントロールされた回答が可能に

3.2023年4月までの最新の情報にアクセスが可能

4.APIが総まとめに 新しいモダリティ:画像生成, 画像理解, 音声合成 APIが公開!

5.カスタマイゼーション

6.レートの引き上げと引き下げ/著作権シールド

・新機能GPTsにより自分だけのbotの作成が可能、販売も

・新機能Assistants APIによりアプリ作成の効率化を実現

早速ですが皆さんが気になっているのはこのChatGPTの新機能達でしょう。

順々に紹介していきます。

ChatGPTの新モデルGPT-4 Turboの発表、APIが総まとめで公開!!

YoutubeOpenAI DevDayより引用

これらの進化により、ChatGPTユーザーはより多様で高度な機能を活用することが可能になります。

1.OpenAI DevDay発表:送信できる文章の長さが12万8千トークンに拡大!!

YoutubeOpenAI DevDayより引用

文章の長さとは、GPT-4が入力として受け取れるテキストの長さのことです。これまでは32kトークン(約8,000単語)でしたが、OpenAI DevDayで発表されたGPT-4 Turboという新しいバージョンでは、文章の入力できる長さが128kトークン(約100,000単語)に拡大されました。これにより、より長いテキストを入力として使えるようになり、より複雑なタスクやより高度な応答が可能になりました。例えば、300ページ程度の本を入力として使って、要約や感想を生成することができます。

これ、どれぐらいの衝撃かってフリーザの戦闘力ぐらいやばいです。

Claude 2のトークン数と比較してみましょう。

| 名称 | トークン数 |

| Claude 2 | 最大100,000トークン(約75,000語) |

| GPT4 Turbo | 最大128,000トークン(約100,000語) |

注意点はあくまで入力がたくさん入れられるだけであって回答出力は4096トークンまでとなっています。あくまで入れられるのが10万文字程度。

トークン数が多いと精度も下がると言われていますが、今回の発表では精度も維持されると言われていました。

Claude 2の詳細は下記記事をご覧ください。

【日本語対応】ChatGPTのライバルClaude 2(Claude2)の使い方【最新情報】

今日から使えます。

2.OpenAI DevDay発表:コントロールされた回答が可能に

アプリケーションや外部APIの機能をモデルに説明させ、その機能を呼び出すためのJSONオブジェクトを出力できるようになりました。これによって、モデルが外部の機能を理解し、対話型のインターフェースを通じて直接実行できるようになることで、開発者はよりダイナミックでインタラクティブなアプリケーションを作成することが可能になります。

またコントロールとは、GPT-4の出力を制御するための機能のことです。これまでは、テキストのスタイルやトーン、言語、ドメインなどを指定することができましたが、OpenAI DevDayで発表された新しい機能では、より細かくコントロールできるようになりました。例えば、以下のようなことができます。

- テキストのフォーマットを指定することができます。例えば、MarkdownやHTMLなどの形式で出力することができます。

- テキストの品質を指定することができます。例えば、正確さや信頼性、一貫性などの指標で出力の品質を調整することができます。

- テキストの目的を指定することができます。例えば、説得力や感情移入、エンターテイメントなどの目的で出力の効果を最適化することができます。

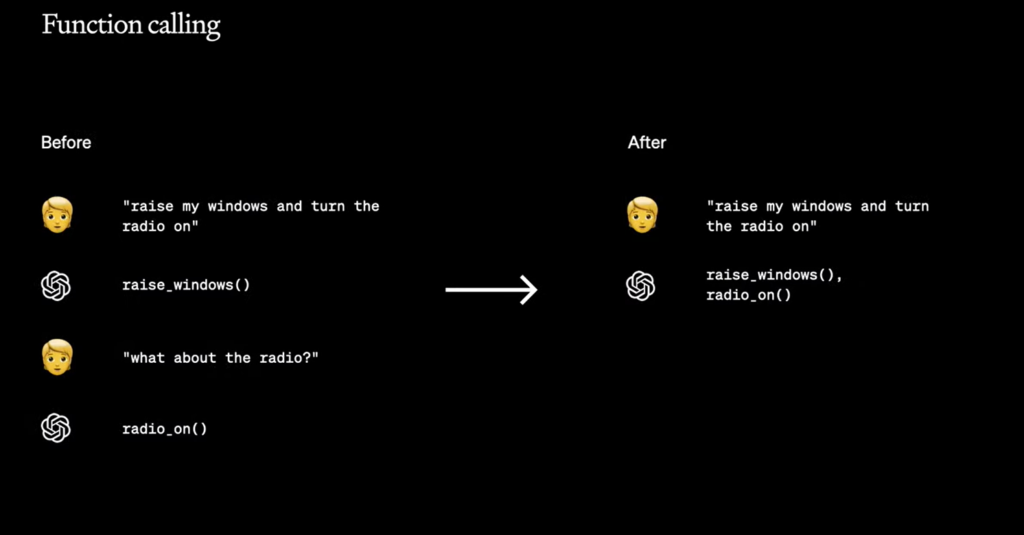

OpenAIがFunction callingの機能をアップデートし、複数の操作を必要とする指示を一つのメッセージで処理できるようになりました。「車の窓を開けてエアコンをオフにする」といった指示が単一のメッセージで送信可能です。

YoutubeOpenAI DevDayより引用

上記の画像の通り、一回一回こちらから回答を聞き出しにいっていたのに対して、Afterで会話一つなげただけで正確な回答をしてもらえるようになりました。

要するに賢くなったおかげで楽にGPTが使えるという事です。今日から使えるとのことです!

3.OpenAI DevDay発表:2023年4月までの最新の情報にアクセスが可能

YoutubeOpenAI DevDayより引用

GPT APIの知識幅とは、GPT-4が持っている知識の範囲のことです。これまでは、GPT APIでは、GPT-4が2021年4月までのインターネット上の情報を学習していましたが、OpenAI DevDayで発表されたGPT-4 Turboでは、GPT-4が2023年4月までのインターネット上の情報を学習しています。これにより、より新しい情報やトレンドに対応できるようになりました。例えば、最新のニュースやイベントに関する質問に答えることができます。

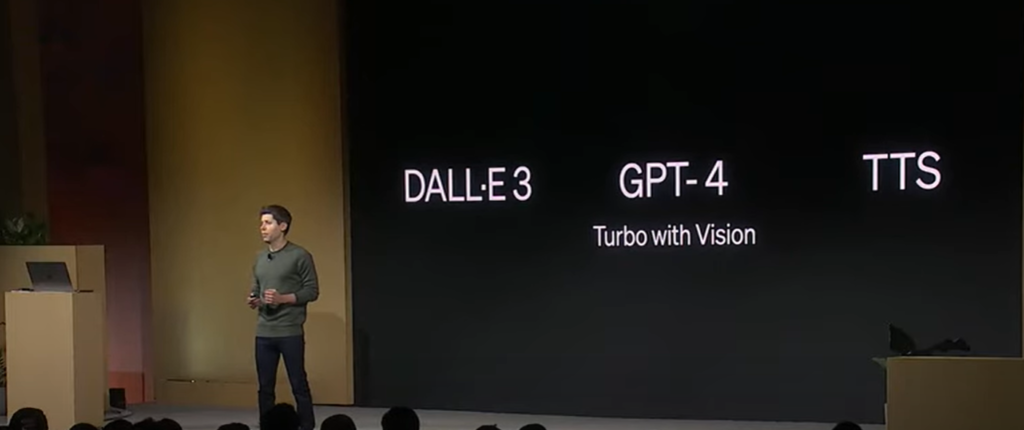

4.OpenAI DevDay発表:APIが総まとめに 新しいモダリティ:画像生成, 画像理解, 音声合成 APIが公開!

YoutubeOpenAI DevDayより引用

GPTのモダリティとは、GPT-4が扱えるデータの種類のことです。これまでは、GPT APIでは、テキストのみを入力と出力として使えましたが、OpenAI DevDayで発表された新しいAPIでは、画像や音声も入力と出力が使えるようになりました。以下のような新しいAPIが公開されました。

- 画像生成 API: テキストを入力して、画像を出力する生成するAPIです。例えば、”a dragon”というテキストを入力すると、ドラゴンの画像を出力します。

- 画像理解 API: 画像を入力して、テキストを出力する生成するAPIです。例えば、人物の画像を入力すると、人物の名前や特徴を出力します。

- 音声合成 API: テキストを入力して、音声を出力する生成するAPIです。例えば、”Hello, this is Bing.”というテキストを入力すると、Bingの音声で挨拶を出力します。

GPT-4 Turboの視覚機能: GPT-4 Vision API

YoutubeOpenAI DevDayより引用

GPT-4 Turboに組み込まれた新しい視覚機能であるGPT-4 Vision APIは、画像を入力として受け取り、それに対するキャプション生成、画像内容の詳細分析、図表が含まれる文書の理解といった機能を提供します。この進歩は、例えばBeMyEyesのようなアプリケーションによって、視覚障害者が日常生活で直面する課題を解決するのに活用されています。

具体的にはこんな事ができます

- 画像とテキストを組み合わせて対話することができます。例えば、ユーザーが自分の写真をアップロードすると、GPT APIが写真に関するコメントや質問を返すことができます。

- 画像を生成してテキストに説明することができます。例えば、ユーザーが”draw me a picture of a dragon”というテキストを入力すると、GPT APIがドラゴンの画像を生成して、”This is a picture of a dragon. It has scales, wings, and a long tail.”というテキストを返すことができます。

- テキストを音声に変換して読み上げることができます。例えば、ユーザーが”tell me a story”というテキストを入力すると、GPT APIがストーリーのテキストを生成して、音声で読み上げることができます。

これによって障害者のWEBアクセシビリティが実現する社会により近づいたという事が言えます。GPT-4 Vision APIが利用可能になれば、スマートグラスとの連携プログラムを作成することが考えられます。スマートグラスが撮影した家族の写真を自動でGPT-4 Visionに送り、分析させることで、AIキャラクターがその写真について「泣けますね」とコメントするような対話が実現可能になるでしょう。このプログラムはスマートグラスのカメラ、APIの呼び出し、そしてAIキャラクターの音声合成を組み合わせることで構成されます。

GPT-4 Vision APIのすごさ:AIがサッカー実況を生成する

この動画は一切編集していません

スポーツの実況をAIが生成するという驚きの機能を持つChatGPTとTTS(Text to Speech)を組み合わせています

ChatGPTはGPT-4Vという最新の自然言語処理技術を使って、動画の各フレームを解析し、簡単なプロンプトに基づいて実況文を作り出します

この機能を使えば、実況系の動画を簡単に作成できます

開発者は現在、gpt-4-vision-previewというAPIを利用してGPT-4の視覚機能にアクセスできます。安定版がリリースされた際には、この視覚サポートがGPT-4 Turboの主要モデルに統合される予定です。価格は入力画像のサイズに基づくもので、例えば1080×1080ピクセルの画像の場合は$0.00765と設定されています。

画像生成: DALL-E 3 API

YoutubeOpenAI DevDayより引用

ChatGPT PlusおよびEnterpriseユーザーにリリースされた後、開発者はAPIを通じて自身のアプリケーションや製品にGPT-4 Turboの機能を直接統合することが可能になります。企業は、顧客やマーケティングキャンペーン用に画像やデザインを生成するためにこのAPIを活用しています。

GPT-4 Turboには内蔵のモデレーション機能が付属しており、これにより悪用を防止するのに役立ちます。価格設定に関しては、生成された画像一枚あたり$0.04からとなっています。これにより、ユーザーはコストを意識しつつ、安全な方法で画像生成を利用できるようになります。

音声合成: TTS(Text To Speech) API

YoutubeOpenAI DevDayより引用

OpenAIのTTS(Text to Speech)APIが利用可能になり、テキストから人間のような音声を生成することができます。ユーザーは6種類のプリセットされたボイスから選択可能で、さらに2つの異なるモデルバリアント(tts-1とtts-1-hd)を利用できます。これにより、開発者はアプリケーションやサービスでより自然な音声体験を提供することができるようになります。

APIを使ったマルチモーダルAIの活用事例7選

すでに発表から数日しか経っていませんが、APIを活用したAIツール・アプリがたくさん登場しています。7個国内外から紹介させていただきます。

1.Webカメラ(これはスマホから)に映ってる状況を解説してくれるツール

Webカメラ(これはスマホから)に映ってる状況をGPT4VのAPIで読み取って解説してくれる!

2.そいつっぽいペンギンジェネレーター

GPT-4VとDALL-E 3のAPIが開放されたことで、様々なクリエイティブなコンテンツの生成が可能になりました。その中でも、顔写真をアップロードすると、その人っぽい雰囲気のペンギンを生成する謎ジェネレータ。

3.ナルトと会話が可能?!キャラまねくん

AIは、キャラの見た目からそのキャラの性格や特徴を推測し、それに合った人格のキャラとして会話します。有名なキャラであれば、よりそのキャラらしい会話を楽しむことができます。

4.ラフからhtmlを生成ツール

5.ゲーム実況自動化ツール

Youtuberも自動化される時代に!!

6.食材の写真を送るとレシピを作ってくれるツール!

もう毎日の献立に悩まない!

7.今着てる服へのファッションアドバイザーAI

ZOZOあたりがそわそわしてそうなwめっちゃ面白いです。

5.OpenAI DevDay発表:カスタマイゼーション

YoutubeOpenAI DevDayより引用

OpenAIはモデルのカスタマイズとGPT-4のファインチューニング実験アクセスを開始しました。

GPT-3.5のファインチューニングに比べてGPT-4はさらなる作業を必要としていますが、品質と安全性が向上するにつれて、開発者にはGPT-4プログラムへの応募オプションが提供されます。

また、特定分野に特化したカスタムGPT-4モデルを作成するカスタムモデルプログラムも始まっており、選ばれた組織はOpenAIのチームと協力してトレーニングできます。これはプライバシーを保護する方針の下で実施され、当初は限定的かつ高価なプログラムとして提供されます。興味のある組織は応募可能です。

6.OpenAI DevDay発表:レートの引き上げと引き下げについて/著作権シールド

レートの引き上げ

YoutubeOpenAI DevDayより引用

GPT APIを利用する際に、一定時間内に送信できるリクエストの数を制限するレート制限が、全ての有料プランで2倍に引き上げされました。これにより、アプリケーションのスケールアップをサポートします。

新しいレート制限は、レート制限ページで確認できます。画像 利用量を明示し、レート制限の自動増加の仕組みを説明しました。

アカウント設定から、利用限度の増加を申請できるようになりました。

著作権シールド

YoutubeOpenAI DevDayより引用

OpenAIは、システム内に組み込まれた著作権保護機能により、顧客の安全を守っています。

さらに、新たに「著作権シールド」を導入しました。これは、顧客が著作権侵害の法的な問題に巻き込まれた場合に、OpenAIが介入して、発生した費用を負担するというサービスです。

このサービスは、ChatGPT Enterpriseと開発者プラットフォームの一般利用者に適用されます。

これはすごい!

レートの引下げ

GPT APIの料金が全体的に下がりました。

GPT APIの価格とは、GPT APIを利用するために支払う料金のことです。これまでは、GPT APIの価格は、以下のように設定されていました。

- ベースプラン: 月額$100で、1日あたり10,000トークンまで利用できるプランです。

- スタンダードプラン: 月額$500で、1日あたり100,000トークンまで利用できるプランです。

- プレミアムプラン: 月額$2,000で、1日あたり1,000,000トークンまで利用できるプランです。

- エンタープライズプラン: 月額$10,000で、1日あたり10,000,000トークンまで利用できるプランです。

OpenAI DevDayで発表された新しい価格では、これらのプランの価格が半分になりました。つまり、以下のようになりました。

- ベースプラン: 月額$50で、1日あたり10,000トークンまで利用できるプランです。

- スタンダードプラン: 月額$250で、1日あたり100,000トークンまで利用できるプランです。

- プレミアムプラン: 月額$1,000で、1日あたり1,000,000トークンまで利用できるプランです。

- エンタープライズプラン: 月額$5,000で、1日あたり10,000,000トークンまで利用できるプランです。

これにより、GPT APIの利用がより手頃になりました。また、新しいAPIや機能の追加に伴って、トークンの消費量が増えることも考慮して、レート制限も引き上げられました。レート制限とは、GPT APIを利用する際に、一定時間内に送信できるリクエストの数のことです。これまでは、レート制限は、以下のように設定されていました。

- ベースプラン: 1秒あたり10リクエストまで送信できる。

- スタンダードプラン: 1秒あたり100リクエストまで送信できる。

- プレミアムプラン: 1秒あたり1,000リクエストまで送信できる。

- エンタープライズプラン: 1秒あたり10,000リクエストまで送信できる。

OpenAI DevDayで発表された新しいレート制限では、これらの制限が10倍になりました。つまり、以下のようになりました。

- ベースプラン: 1秒あたり100リクエストまで送信できる。

- スタンダードプラン: 1秒あたり1,000リクエストまで送信できる。

- プレミアムプラン: 1秒あたり10,000リクエストまで送信できる。

- エンタープライズプラン: 1秒あたり100,000リクエストまで送信できる。

これにより、GPT APIの利用がより快適になりました。OpenAIは、GPT APIの価格とレート制限を引き下げることで、より多くの開発者にGPT APIを使ってもらうことを目指しています。

ファインチューニングされたGPT-3.5 Turbo 4Kモデルの入力トークンは、4分の1の$0.003、出力トークンは2.7分の1の$0.006になりました。ファインチューニングは、新しいGPT-3.5 Turboモデルで、4Kと同じ料金で16Kコンテキストに対応できます。これらの新料金は、ファインチューニングされたgpt-3.5-turbo-0613モデルにも適用されます。

OpenAI DevDay発表:新機能①「GPTs」で誰でもノーコードで自分だけのChatGPTが作成販売が可能に

YoutubeOpenAI DevDayより引用

Custom Instructionsのリリースに続き、ユーザーからのより細かなカスタマイズ要求が増加している中、GPTsはこれらの要望に応え、プリセットされたプロンプトや指示に基づいて自動操作を可能にします。

GPTsは公開され、ユーザーは自作のGPTを共有できるようになり、GPT Storeの立ち上げも予定されており、認証されたビルダーの作品が展示されます。

CanvaとZapierは、特定のユーザー向けにGPTsの提供を開始しています。

GPT Storeの登場

GPTsで構築したGPTを世界に公開できるプラットフォームが今月末に登場します。

いわゆるAppleストアでiPhoneアプリが販売できるようなイメージです。開発者はGPT Storeを通じて自分たちが開発したGPT製品を市場に出すことが可能になります。これにより、独自のAIソリューションを創出し、それを収益化する新たな道が開かれています。

GPTsは私が一番衝撃を受けた情報でした。ノーコードで世界の皆を便利にするようなGPTが作れるのはすごい!「コーチングGPT」「ダイエット専門GPT」などなど・・・これで収益がもらえるなんて夢が広がります!

イメージは下記動画をご覧いただくとわかるかと思われます。

プライバシーとセキュリティは重視され、データの共有はユーザーの手に委ねられます。GPTsは実世界のタスクに対応し、企業は独自のデータセットに合わせたGPTを構築し、その共有や使用を管理できます。

OpenAI DevDay発表:新機能②開発者のアプリ開発が楽になる「Assistants API」

YoutubeOpenAI DevDayより引用

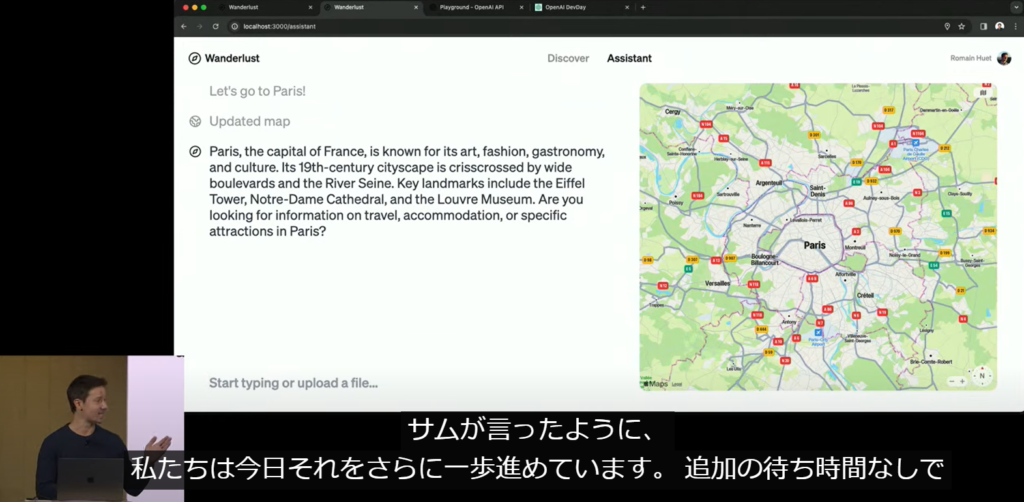

新しいAssistants APIは、開発者にとって大幅な簡略化をもたらします。従来、手動で行う必要があった複雑なプロセスを排除し、Code InterpreterやRetrievalなどの機能を通じて、高品質なAIアプリケーションの開発を容易にします。また、関数呼び出し機能も提供し、開発者はこれを活用してAPIを介して特定のアクションを実行できるようになります。

YoutubeOpenAI DevDayより引用

Assistants APIを使用すると、開発者はアプリケーション内で外部情報を活用してタスクを実行するAIアシスタントを統合できます。DevDayのデモでは、コーディング支援や旅行計画アプリケーションなどが紹介されました。

このAPIは関数呼び出しをサポートしており、開発者が定義した関数を呼び出して応答をメッセージに組み込むことが可能です。現在β版で提供されており、OpenAIに登録した開発者が利用可能です。料金体系はトークンベースで、将来的にはさらに多くのカスタムドライブツールが追加される予定です。

OpenAI DevDayに参加(動画視聴)した人達の口コミ

私も動画を視聴して思ったのがAppleの新作発表を彷彿とさせる、時代を切り開くワクワク感を感じました。ChatGPTに全く詳しくない人でも一度はこの何かがこれから起こるワクワク感を動画を見て感じ取ってほしいです。(動画は下記からご覧になれます。)

ChatGPTの進化によって起こるこれからのの展望

①既存のAIアプリが進化+収入化 ・APIの利用料が安くなる ・トークンが128Kに増えて機能が充実する

②自分だけのBotが作れるようになる ・コーディング不要で自分のファイルを学習させてAIぼっとを作成できる ・個人や企業がAIチャットボットを持つのが普通になる

③画像の解析・生成に関するアプリが続々登場 ・GPT-4VとDalle-3のAPIがついに公開される・アプリのアイディア ・ARグラスで見えるもの全てをAIが解析する ・図面をAIが読み取って説明する ・デザインをAIが自動で改善する ・画像からAIがデザインを作る

ワクワクでしかないです!

OpenAI DevDay まとめ

初の試みであるOpenAI DevDay、大成功を遂げたみたいですね。

何やらAppleの新製品が発表されるドキドキワクワク感を私は覚えました。

今後は全世界国民の注目の的となるように進化したChatGPTへの期待を込めて次回はさらに盛り上がる事を期待しています!

趣味:業務効率化、RPA、AI、サウナ、音楽

職務経験:ECマーチャンダイザー、WEBマーケティング、リードナーチャリング支援

所有資格:Google AI Essentials,HubSpot Inbound Certification,HubSpot Marketing Software Certification,HubSpot Inbound Sales Certification

▼書籍掲載実績

Chrome拡張×ChatGPTで作業効率化/工学社出版

保護者と教育者のための生成AI入門/工学社出版(【全国学校図書館協議会選定図書】)

突如、社内にて資料100件を毎月作ることとなり、何とかサボれないかとテクノロジー初心者が業務効率化にハマる。AIのスキルがない初心者レベルでもできる業務効率化やAIツールを紹介。中の人はSEO歴5年、HubSpot歴1年