これ、あれ、最近話題の「Dream Machine」?ただの北川景子?

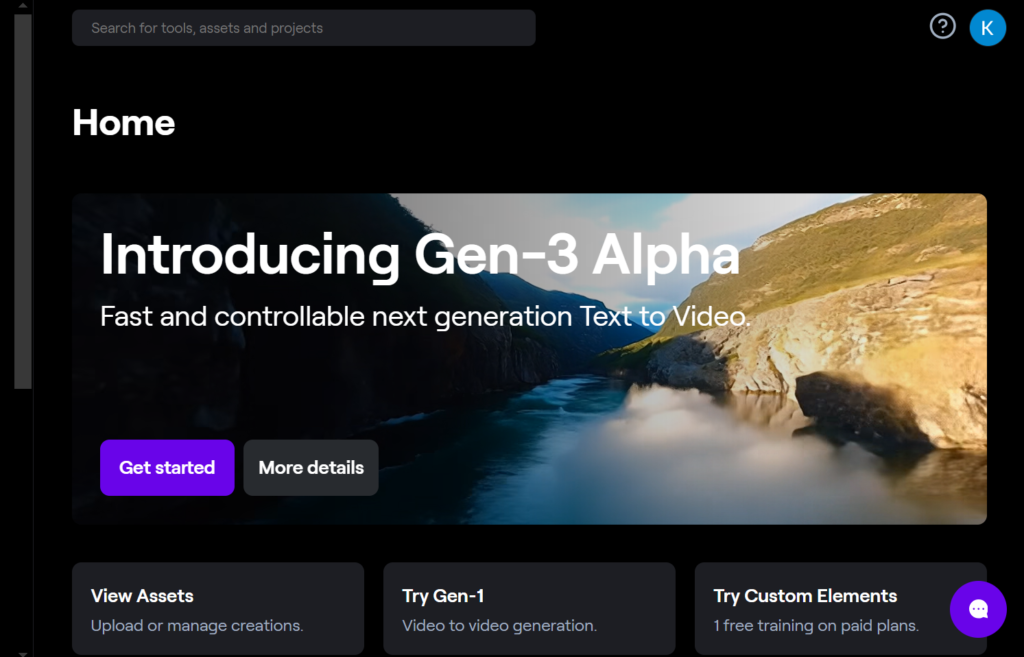

runwayより引用

いえ、違うんです。「Runway Gen2」という動画生成AIを覚えていますか・・・?(遠い目)実際に過去のモデルと以下は比較したものです。左が「Runway Gen2」右が「Gen-3 Alpha」

もはや映画ですよね。

最近、「Dream Machine」でも最高の動画クオリティで使えるようになりましたが、絶対に影響されてますよね・・・。

いや最初からその技術持ってるならださんかーいw

近年、AI技術の進化は目覚ましく、その中でも特に注目を集めているのが動画生成AIです。AI企業Runwayが新たに発表した「Runway Gen-3 Alpha」は、その最前線に立つ革新的なモデルです。

この新しい動画生成AIモデルは、複雑なシーンの変更やシネマティックな選択肢、詳細なアートディレクション機能を備え、クリエイティブな表現の幅を大きく広げることが期待されています。この記事では、Runway Gen-3 Alphaの特徴や使い方、参考動画、利用開始時期などについて詳しく解説します。動画生成AIの未来を切り開くRunway Gen-3 Alphaの全貌に迫りましょう。

圧倒的に高クオリティの動画を今すぐ使いたいなら以下もご覧ください。

この記事はこんな人におすすめ

・最近出た「Dream Machine」と何が違う?

・Runway Gen2と品質はそんなに変わった?

Runway Gen-3 Alphaとは?

runwayより引用

AI企業RundawayはGPUのスケーリングによる性能向上に限界が見え始めたことから、次世代のAIモデルRunway Gen-3を開発した。2024年7月2日よりとうとうリリース!

Runway Gen-3はディープラーニングの手法である拡散モデルに基づいているが、従来とは異なるアプローチを採用している。

拡散モデルとは、注釈付き画像・動画とテキストのペアから概念を学習し、ピクセルのノイズから目的の画像や動画を再構成するよう訓練されたAIモデルである。しかしRunway Gen-3は、画像と動画の両方で共同で学習を行うことで、視覚世界をより本質的に表現できるようになった。

Rundawayは研究者、エンジニア、アーティストからなる分野横断的なチームを結成し、Runway Gen-3の開発に取り組んだ。使用したデータセットの詳細は不明だが、Runway Gen-3は画像生成だけでなく動画生成にも対応する先進的なAIモデルとなっている。

従来の手法の限界に直面し、Rundawayはイノベーティブな発想でGen-3を生み出した。その他、既にGen-2にあるモーションブラシや高度なカメラコントロール機能、ディレクターツールなどのコントロール機能を今後強化していく予定とのことです。視覚表現能力の大幅な向上が期待されており、クリエイティブな分野での活用が注目される。

Runway Gen-3 Alphaが登場した背景

Runwayは、2023年2月にGen-1モデル、2023年6月にGen-2モデルをリリースしており、これらのモデルは高品質な生成AI動画作成に注力してきました。しかし、他のAI動画ジェネレータとの競争が激化する中、Runwayはさらに進化したモデルを開発する必要がありました。

Runway Gen-3 Alphaは、大規模なマルチモーダルトレーニング用に構築された新しいインフラストラクチャ上でトレーニングされており、現実世界で遭遇するような幅広い状況や相互作用を表現し、シミュレートすることができる「一般的な世界モデル」を構築するためのステップとなっています。

2024年5月~6月に中国の企業「Kling」やサンフランシスコの「Dream Machine」などSNS上では大きくバズっています。以下はそれぞれの動画を比較したものです。かなりクオリティが高く「Runway」も焦ったに違いありません。

以下はそれぞれの動画です。

Dream Machine

Sora

Kling

Runway Gen-3 Alphaは無料で使える?

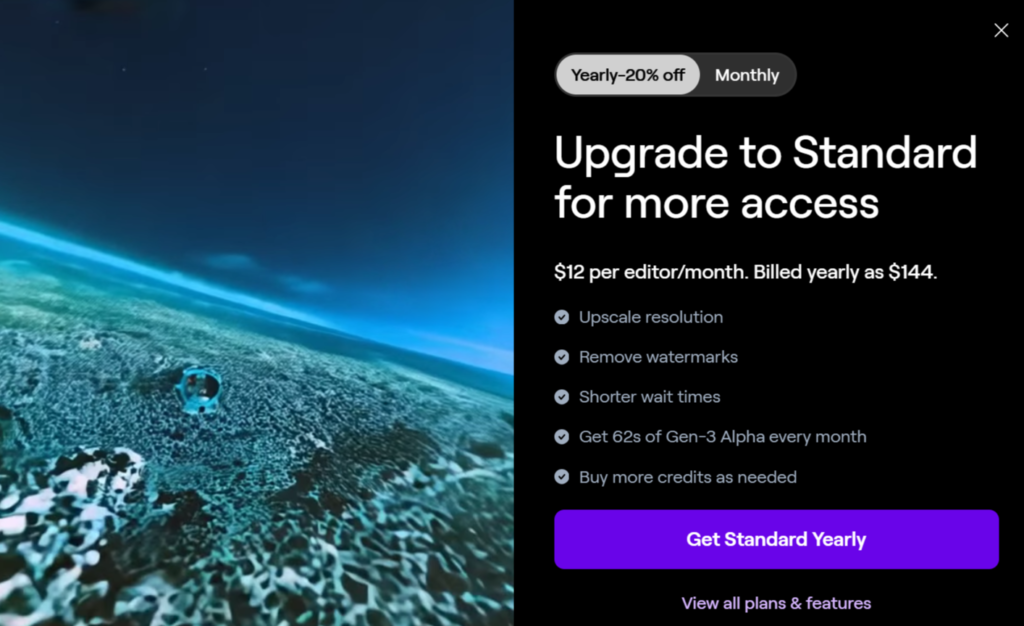

結論から言うと無料で使えません。Runway Gen-3 Alphaが使えるのは有料会員になります。

月3,000円を払えば使えるようになるので、1か月限定で試してみるのもアリだと考えます。

| 項目 | 詳細 |

|---|---|

| プラン名 | スタンダード月額プラン |

| 料金 | 編集者1人あたり月額15ドル |

| 割引 | 年間契約で20%オフ |

| 特徴 |

|

Runway Gen-3 Alphaリリース後の所感

実際に使ってみましたが、以下のような所感があります。今有料課金をしてもできることに制限があります。※後、かなり重いです。

| 評価項目 | 詳細評価 |

|---|---|

| 生成速度 |

|

| 出力品質 |

|

| 生成制御 |

|

| 特徴的な生成能力 |

|

| 今後の期待 |

|

Runway Gen-2とRunway Gen-3 Alphaの違いは?

現在使えるRunway Gen-2とGen-3 Alphaの違いを表にしてまとめました。

| 特徴/機能 | Runway Gen-2 | Runway Gen-3 Alpha |

|---|---|---|

| 動画長さ | 最大16秒 | 5秒〜最大10秒 |

| 生成元素材 | テキスト、画像、ビデオクリップ | テキスト、画像、複合要素 |

| 生成可能コンテンツ | テキストや画像からの動画生成のみ | テキスト/画像から動画/静止画を自在に生成 |

| Motion Brush | 静止画部分の動き付加が可能 | 高度なMotion Brush機能で細かい動きも制御可能 |

| Director Mode | カメラ動きのシミュレート機能 | アートディレクション機能で映像構図を詳細に指示可能 |

| 学習インフラ | 未記載 | 大規模マルチモーダル学習用の新しい高性能インフラ |

| セーフティ | 未対応 | 頑健性の高いモデレーション、C2PA準拠のAI倫理基準 |

| カスタマイズ | なし | メディア業界向けのカスタムバージョンあり |

| 主要機能 | Motion Brush、Director Mode | Motion Brush、高度カメラコントロール、Director Mode |

主な違いは、Gen-3はコンテンツ生成の自由度が格段に高く、付加機能も大幅に強化されている点にあります。一方Gen-2は秒数は長く生成でき、操作が単純で扱いやすい反面、機能面では制限が多いことがわかります。

Runway Gen-3 Alphaの使い方

Runway Gen-3 Alpha自体は2024年7月2日に使えるようになりました。

Runwayの製品は、テキストから動画、画像から動画、動画から動画といった既存のモードをRunway Gen-3 Alphaでも使えるようになる予定です。

具体的な使い方としては、ユーザーがテキストや画像を入力することで、AIがそれに基づいた動画を生成します。例えば、「日本の都市を超高速で移動する電車の窓に映る女性の微妙な表情」といったプロンプトを入力すると、そのシーンが生成されます。

以下より登録~使い方までを解説します。

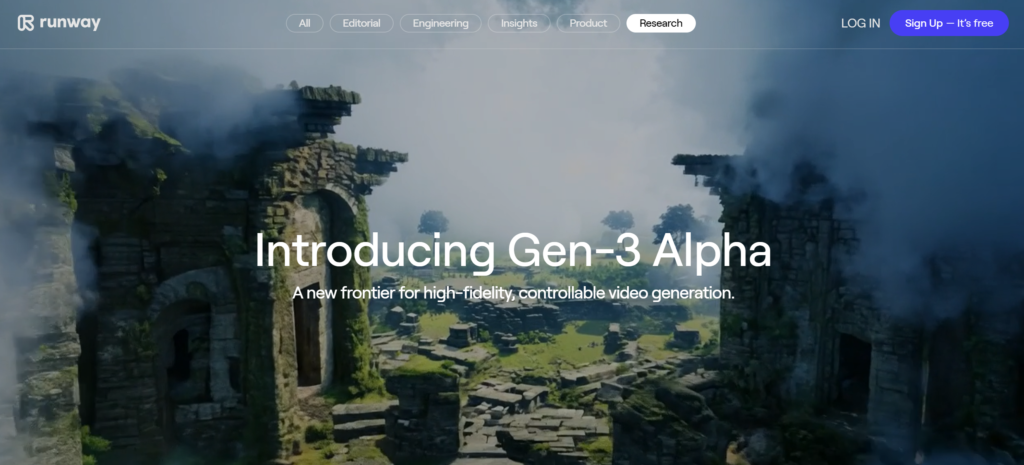

①公式サイトをクリック

右上の「Sign Up – it`s free」のボタンを押下

②アカウントごとにボタンを押下

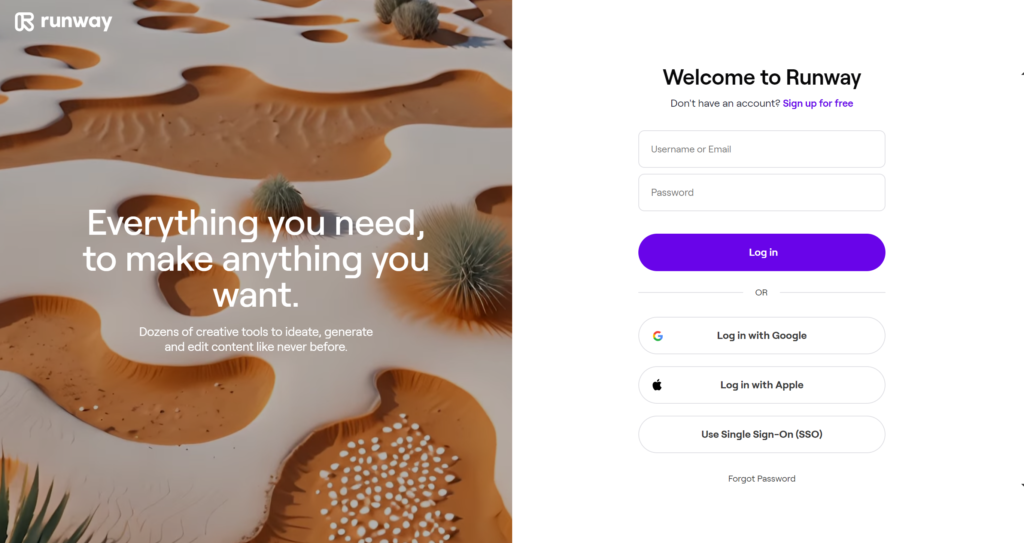

この画面になれば準備完了です。

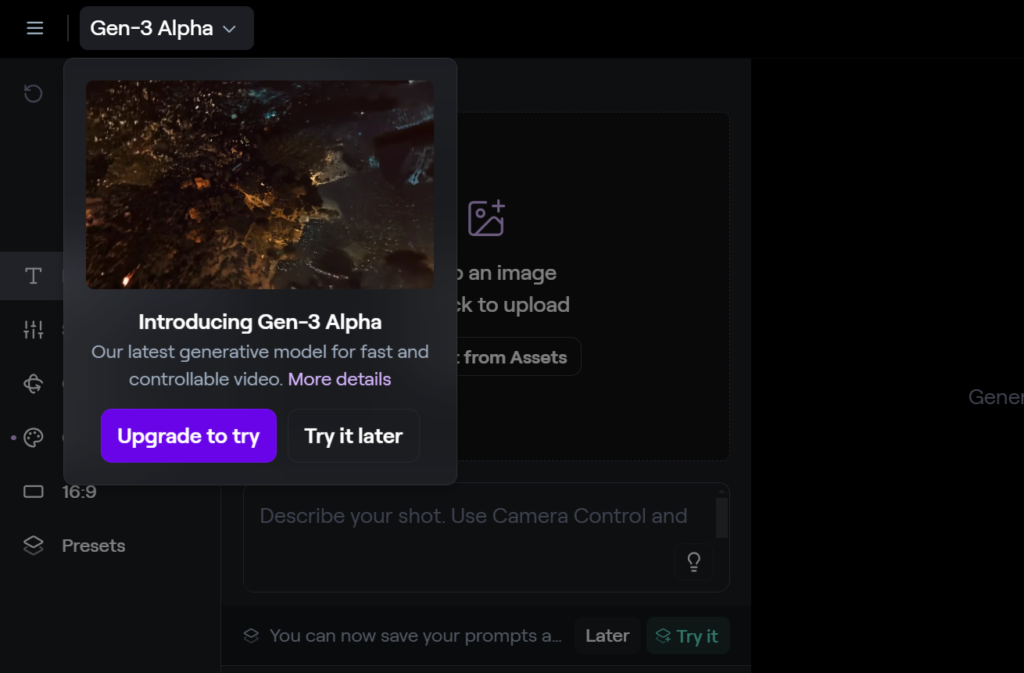

③「Get started」を押下、左上の「Gen-3 Alpha」→「Upgrade to try」を押下

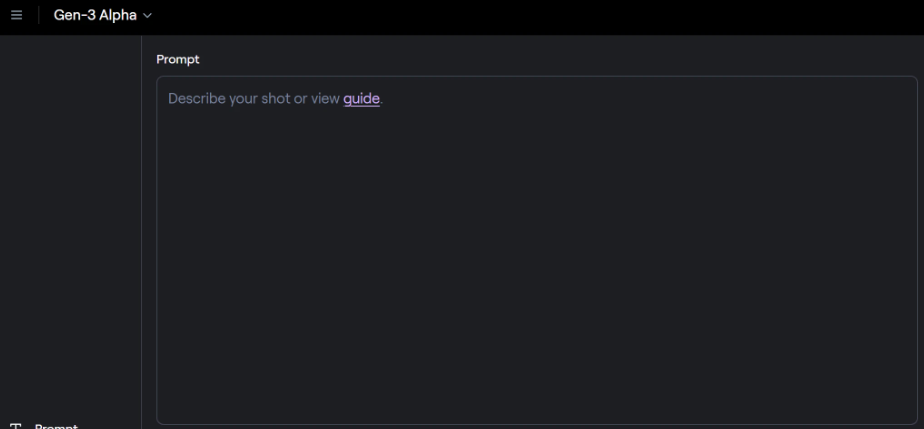

④月額か年額を選択して課金をします。

⑤Gen2と同様にプロンプトを入力して動画を生成します。

Runway Gen-3 Alphaでできる3つのこと

きめ細かな時間制御

Runway Gen-3 Alphaは、詳細な時間情報を活用してトレーニングされており、想像力豊かなトランジションや正確なタイミングでのキーフレーミングを実現します。さまざまなシーンの描写が可能で、例えば巣から出てくるアリの超クローズアップから住宅街への切り替えなど、動的なカメラワークを実現できます。

Runwayより引用

プロンプト:巣から出てくるアリの超クローズアップショット。カメラが引くと、丘の向こうの住宅街が映し出されます。

Runwayより引用

プロンプト:FPV ドローンが崖の上の城を撮影しました。

フォトリアリスティックな人間キャラクター

Gen-3 Alphaは、様々な感情表現や動作を備えた人物キャラクターを生成することに長けています。照明や構図を意識したポートレートはもちろん、宇宙服を着た人物が石造りの建物の間を歩くような不思議なシーンも描くことができます。新しいストーリーテリングの可能性が広がります。

Runwayより引用

プロンプト:石造りの建物の間を歩く宇宙飛行士。

Runwayより引用

プロンプト:テレビの光で顔を照らされた男性の映画のようなワイドポートレート

アーティストによる、アーティストのための設計

Gen-3 Alphaの開発には、研究者、エンジニア、アーティストからなる学際的なチームが関わり、幅広いスタイルや映画用語を解釈できるよう設計されています。奇抜でファンタジックなシーンを生成できるほか、ジャンルを超えた表現が可能で、アーティストのクリエイティビティを存分に発揮できるでしょう。

Runwayより引用

Runway Gen-3 Alphaの活用事例

早速Runway Gen-3 Alphaを活用し、SNSでは話題になっています。その活用事例を一部紹介します。

日本人も普通に出せる

アジア人だと顔がゆがむことが多かったですが、これはすごい。

渋谷の待ちを歩く美女

ドラマの撮影でも使われそうですね。

ファッションショーにも

ラーメンを食べるパンダ

ホリエモンのセンスすごいですね

スライスカット

料理動画の作成も!

Runway Gen-3 Alphaはいつから使える?

Gen-3 Alphaは、2024年7月2日より使用の開始がなされました。

最初のリリースでは、5~10秒の動画生成機能が利用可能で、5秒の動画を生成するのに45秒、10秒の動画を生成するのに90秒の時間がかかります。なお、最初はRunwayの有料サブスクリプションユーザー向けに提供される予定です。

Runwayの料金表は以下の通りです。

年額プランと月額プランをまとめた料金表です。

| プラン | 月額料金 | 年額料金 | クレジット | 機能 | アセット |

|---|---|---|---|---|---|

| スタンダード | $15 / 編集者ごと / 月額 | $12 / 編集者ごと / 月額 ($144 年額) | 625クレジット / 月 | – クレジットは毎月625にリセット – 解像度アップスケールと透かし除去 (Gen-1, Gen-2) – Gen-1 (ビデオからビデオ) 最大15秒 – Gen-2 (テキストからビデオ) 最大16秒(エクステンドビデオ) – 無制限のビデオ編集プロジェクト | 100GB |

| プロ | $35 / 編集者ごと / 月額 | $28 / 編集者ごと / 月額 ($336 年額) | 2250クレジット / 月 | – クレジットは毎月2250にリセット – 解像度アップスケールと透かし除去 (Gen-1, Gen-2) – Gen-1 (ビデオからビデオ) 最大15秒 – Gen-2 (テキストからビデオ) 最大16秒(エクステンドビデオ) – 無制限のビデオ編集プロジェクト | 500GB |

| アンリミテッド | $95 / 編集者ごと / 月額 | $76 / 編集者ごと / 月額 ($912 年額) | 無制限のビデオ生成 | – プロプランの全機能 – リラックスレートでのGen-1およびGen-2の無制限生成(エクスプローモード) – クレジット(レート制限なし)は毎月2250にリセット | |

| エンタープライズ | – | $125 / 編集者ごと / 月額 ($1500 年額) | スケーラブル | – プロプランの全機能 – シングルサインオン – ワークスペース分析 – アセットのセグメント化および整理のための構成可能なチームスペース – 企業全体のオンボーディング – 優先サポート – 無制限のチームメンバー |

動画生成AIがAIの一歩先へ

Gen-3 Alphaの登場は、動画生成AIの新たな一歩を示しています。この技術の飛躍的進歩は、アーティストを支援し、次世代の創造的かつ芸術的な革新への道を切り開く重要なマイルストーンとなります。Runwayは、今後もエンターテインメントやメディア組織と協力し、カスタムバージョンの開発を進めていく予定です。これにより、よりスタイル制御された一貫性のあるキャラクターの生成が可能になり、特定の芸術的および物語的要件をターゲットにすることができます。

Gen-3 Alphaは、研究科学者、エンジニア、アーティストからなる学際的なチームによる共同作業で開発されました。これにより、クリエイティブな用途向けに徹底的にトレーニングされた動画生成AIモデルが誕生しました。今後もRunwayは、さらなる技術革新を追求し、アーティストやクリエイターに新たなツールを提供していくことでしょう。

趣味:業務効率化、RPA、AI、サウナ、音楽

職務経験:ECマーチャンダイザー、WEBマーケティング、リードナーチャリング支援

所有資格:Google AI Essentials,HubSpot Inbound Certification,HubSpot Marketing Software Certification,HubSpot Inbound Sales Certification

▼書籍掲載実績

Chrome拡張×ChatGPTで作業効率化/工学社出版

保護者と教育者のための生成AI入門/工学社出版(【全国学校図書館協議会選定図書】)

突如、社内にて資料100件を毎月作ることとなり、何とかサボれないかとテクノロジー初心者が業務効率化にハマる。AIのスキルがない初心者レベルでもできる業務効率化やAIツールを紹介。中の人はSEO歴5年、HubSpot歴1年