この記事では、ChatGPTの画像認識機能であるGPT-4Vの使い方について紹介します。GPT-4Vとは、OpenAIが開発した最新のマルチモーダルAIモデルで、2023年9月25日以降でもテキストだけでなく画像も理解するようにOpenAIは2週間をかけて実装を開始するとのことです。

この記事では、以下の内容について解説します。

・GPT-4Vの使い方

・GPT-4Vでできることと弱み

この記事はこんな人におすすめ

・GPT-4Vの導入方法/使い方がわからない

・GPT-4Vの何がすごいのか知りたい

・GPT-4Vがなぜか使えなくて困っている

機能性簡単レビュー | GPT-4V |

会話のスピード | |

事実に基づいている | |

他の画像認識機能と比べてどうか |

- ChatGPTの新機能「GPT-4V(ビジョン)」とは?

- GPT-4Vの音声認識機能もエグイ

- GPT-4(ビジョン)の画像認識機能の導入方法~使い方

- GPT-4(ビジョン)の音声認識機能の導入方法~使い方

- GPT-4V(ビジョン)の3つの機能

- GPT-4V(ビジョン)でできること10選を口コミから集めてみた。

- GPT-4V(ビジョン)のおすすめの活用事例10選

- GPT-4V(ビジョン)、課金したのに使えない!

- GPT-4V(ビジョン)は無料で使える?

- GPT-4V(ビジョン)の安全性確保の取り組みは?

- 現状:GPT-4のここが弱い!画像処理能力が不十分

- ChatGPTのGPT-4Vを使ったユーザーの声

- ChatGPTのGPT-4Vによってどんな社会影響がある?

- GPT-4V(ビジョン)まとめ

ChatGPTの新機能「GPT-4V(ビジョン)」とは?

GPT-4Vは、2023年9月25日にOpenAIが発表した最新のマルチモーダルAIモデルです。マルチモーダルとは、複数の入力手段を組み合わせたものを指します。GPT-4Vでは、テキストだけでなく画像も入力として受け取り、それに基づいて高度な認識や生成タスクを実行することが可能です。

GPT-4Vは、GPT-4の進化版とも言えるモデルです。GPT-4は、2022年6月にOpenAIが発表した大規模言語モデルで、1750億個のパラメータを持ち、インターネット上のテキストデータを学習しています。GPT-4は、自然言語処理や自然言語生成において驚異的な性能を発揮しました。

しかし、GPT-4はテキストだけを扱うことしかできませんでした。

GPT-4Vでは、GPT-4に画像処理能力を追加しました。画像処理能力とは、画像を入力として受け取り、その内容や特徴を分析したり、画像に関する質問に答えたりする能力です。また、画像処理能力によって、テキストから画像を生成したり、画像からテキストを生成したりすることもできます。

ChatGPT、“目”と“耳”の実装を発表 写真の内容を認識、発話機能でおしゃべりも可能に

画像認識技術を用いると、写真、スクリーンショットやテキストと画像が混在するドキュメントを解析できます。OpenAIはこの技術を使って、グリルのトラブルシューティング、冷蔵庫の内容からの食事計画、あるいは業務データの詳細なグラフの分析などを実行できると述べています。

これ、すごいのがGPT-4Vで複数枚の画像読み取りにも対応している点です。

下記のような形で画像で会話が可能です。千と千尋の神隠しのそれぞれのシーンについてしっかり言及してくれています。

スタジオジブリより引用

GPT-4Vの音声認識機能もエグイ

OpenAIは、音声出力の技術として独自の音声合成モデルを構築しており、すでにSpotifyにもその技術が取り入れられています。この動きにより、OpenAIは音声合成分野のサービス提供者として位置づけられ、音声合成スタートアップと競合する状況となりそうです。

OpenAIのAIによる音声技術は、短いサンプル音声を基に、テキストを元の音声スタイルで合成する能力を持っています。ChatGPTで提供される5つの音声は、プロの声優との協力のもと、再現が行われているとされています。

これ、大分未来変わりますよね。

ミュージシャンでいうとボーカルが居なくても助かるという・・・

この音声合成モデルはSpotifyでの利用も明らかにされています。Spotifyは、この技術を使用して、ポッドキャストを他言語に翻訳し、ホストのオリジナルの声で異なる言語を話すことが実現されている。スペイン語が最初に導入され、フランス語やドイツ語のサポートも近日中に追加される予定とのことです。

OpenAIから、新しい音声合成モデルへのアクセスに関する詳細な発表はまだなされていませんがただし、音声クローニングの悪用リスクを鑑みて、初期段階では特定の用途、例えば音声チャットやSpotifyのポッドキャストなど、限定的な展開が行われることが示されています。

GPT-4(ビジョン)の画像認識機能の導入方法~使い方

GPT-4(ビジョン)の画像認識機能の導入方法

GPT-4がChatGPTの最新の大規模言語モデルであった時期がありましたが、現在はGPT-4Vがその地位を引き継いでいます。

GPT-4Vを利用するには「ChatGPT Plus」プラン(月額20ドル)に登録することで、この先進的なモデルを利用できます。

GPT-4Vでは、’V’が「ビジョン」を意味し、画像認識能力がこのバージョンに組み込まれているのが特徴です。

まだChatGPTを体験されていない方のために、ChatGPTとは何か、そしてChatGPT有料版への登録方法についてのコラムもありますので、ご参照ください。

【2023年10月最新情報】ChatGPTとは?初心者完全マニュアル入門

ChatGPT Plus(有料版)の料金や支払い方法について徹底解説

GPT-4(ビジョン)の使い方

GPT-4(ビジョン)の画像認識機能導入方法~使い方は簡単です。

画像認識機能導入方法

①ChatGPTにログイン

②「GPT-4」→「Default」の設定をON!

これだけ!

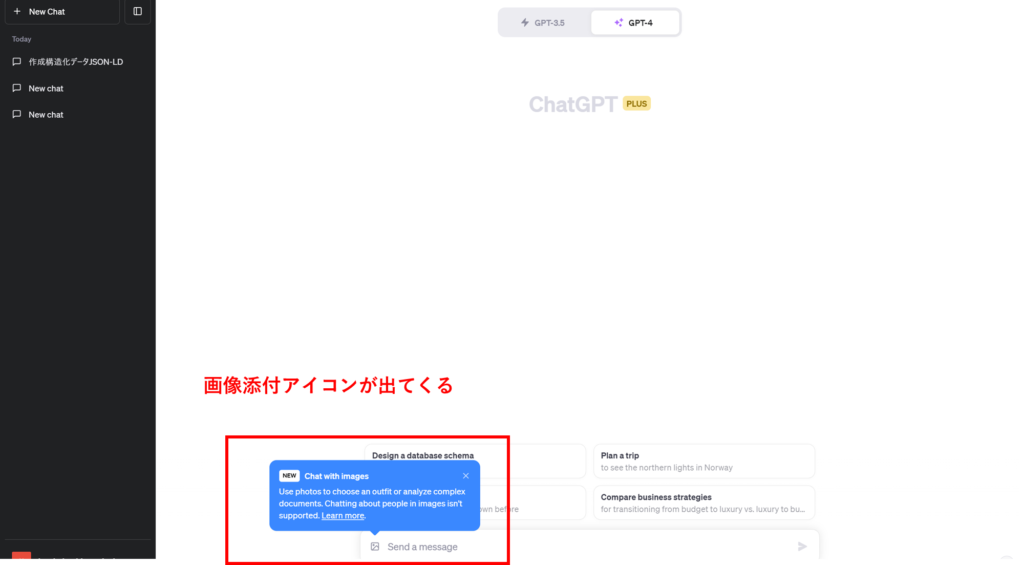

すると下記のような感じでGPT-4(ビジョン)が使えるようになります。画像の添付が出てきたらOKです!

まだ写真添付のアイコンマークが出てくる人とそうでない人がいるのでこの設定をやってもダメな人は気長に待ちましょう。

GPT-4(ビジョン)の音声認識機能の導入方法~使い方

GPT-4V(ビジョン)の音声認識機能導入方法はスマホでのみ対応可能。

実際に下記の手順で設定ができます。

音声認識機能の導入方法

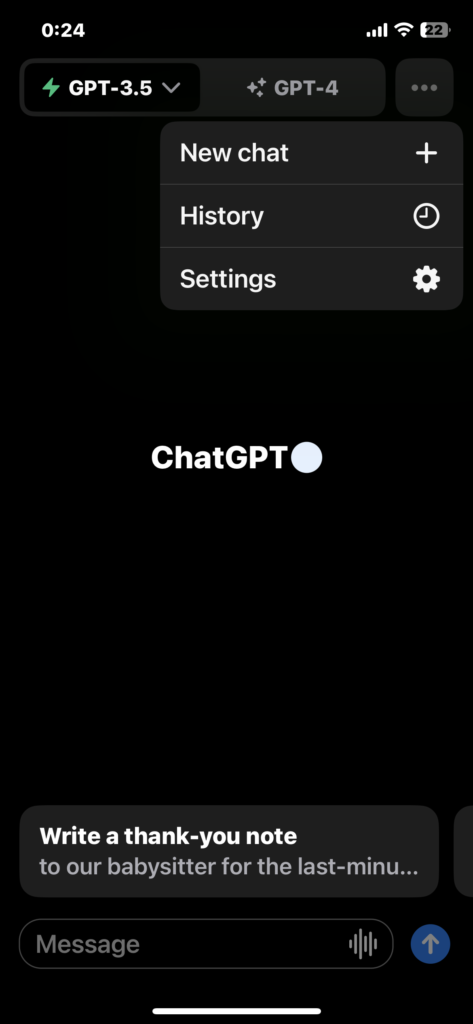

①ChatGPT(スマホ)にログイン

②右上、三点マークをクリック

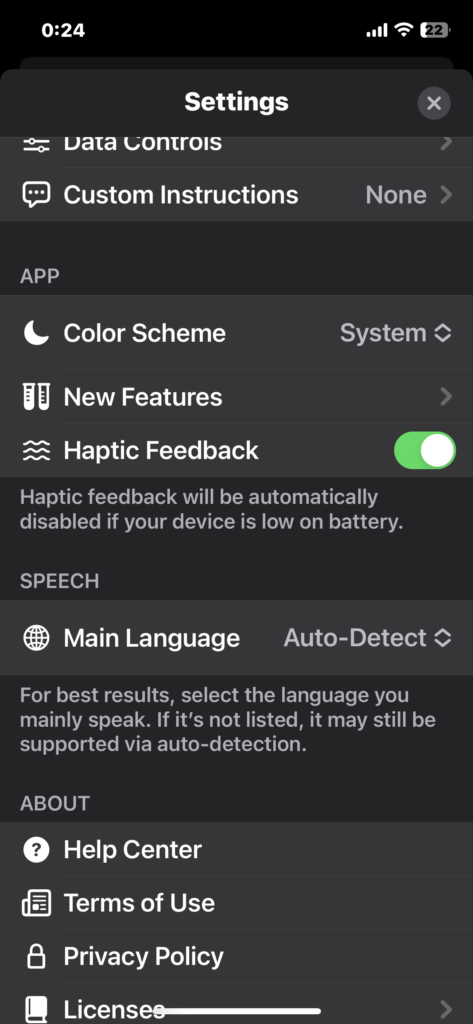

③「Settings」→「New Features」をクリック

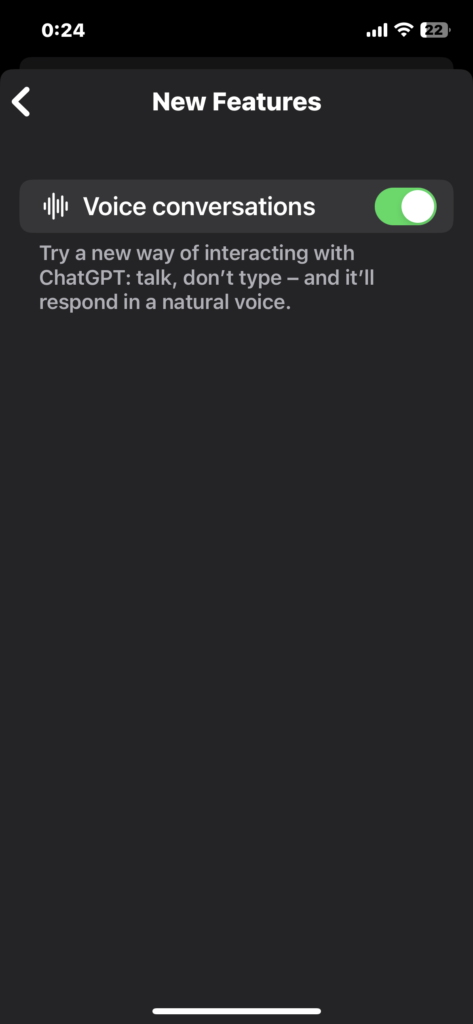

④「Voice conversations」の設定をON!

実際に見てみましょう。

①ChatGPT(スマホ)にログイン

②右上、三点マークをクリック

③「Settings」→「New Features」をクリック

④「Voice conversations」の設定をON!

GPT-4V(ビジョン)の3つの機能

今後ChatGPTのGPT-4V(ビジョン)ではどんなことができるのでしょうか。

GPT-4Vは、テキストと画像を組み合わせたマルチモーダルAIモデルです。そのため、GPT-4Vでは、以下のようなことができます。

画像認識機能

画像認識とは、画像に含まれる物体や人物などの内容や特徴を分析する機能です。

GPT-4Vでは、画像認識を利用することで、画像に関する質問に答えたり、画像に対するコメントや解説などのテキストを生成したりできます。

例えば、「この画像は何ですか?」という質問に対して、「この画像は猫です。白い毛と黒い目が特徴的です」というテキストが生成されます。画像認識は、日本語や英語などの複数の言語に対応しています。

この機能を使う事で例えば会議での壁打ちはもちろん、上司や同僚が良くわからない図を提示してきたときにGPT-4Vにこそっと聞いて意見を求めちゃうこともできますね。

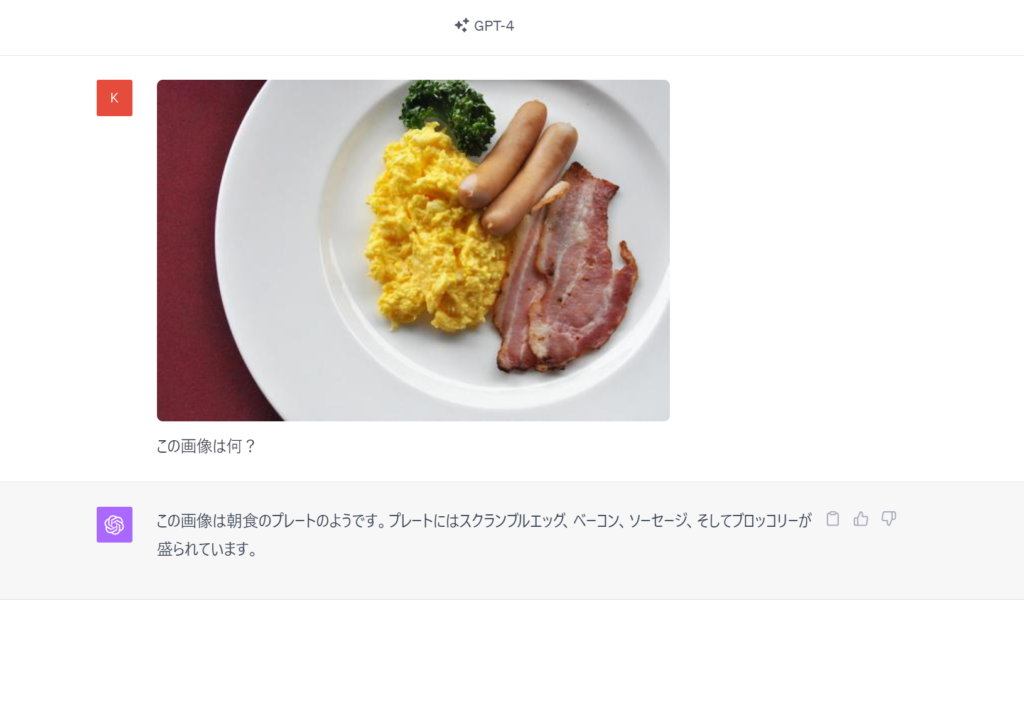

試しにスクランブルエッグの画像が認識できるかやってみました。

素材まであててきて、これはすごいですね。

画像生成機能は使える?

画像生成は、テキストだけでなく画像を生成する機能です。よく勘違いされる方がいますがGPT-4Vでは、画像生成を利用することはできません。しかしChatGPTで画像生成機能は使えます。「DALL-E3(DALLE3)」という機能で2023年10月より日本でも使えるようになりました。

画像生成機能「DALL-E3(DALLE3)」の使い方については下記記事をご参照下さい。

【画像生成機能】ChatGPTの「DALL-E 3(DALLE3)」の使い方

しかし簡易的なイラストであればできます。例えば、「お猿さんの画像作って」というテキストに対して、「お猿さん」風のイラストを生成することはできますね。

正直クオリティはかなり低いですね。

音声機能

GPT-4Vでは、スマホ版で音声機能を利用することができます。

音声認識にはOpenAIの「Whisper」というシステムを採用しています。スマートフォンアプリの「Settings」を開き、「New Features」セクションで音声会話をオンにすると使用できます。音声のタイプは5つから選べます。

GPT-4Vでは、以下のような音声機能を利用できます。

・音声認識

音声認識とは、音声をテキストに変換する機能です。GPT-4Vでは、音声認識を利用することで、マイクなどの音声入力デバイスからチャットに参加できます。例えば、「こんにちは」と話すと、「こんにちは」というテキストが入力されます。音声認識は、日本語や英語などの複数の言語に対応しています。

※今現在でもすでにこのような音声認識機能が使えます。手で触らなくても文章が打てる時代が近づいてますね!

・音声合成

音声合成とは、テキストを音声に変換する機能です。GPT-4Vでは、音声合成を利用することで、スピーカーなどの音声出力デバイスからチャットの内容を聞くことができます。例えば、「こんにちは」というテキストが出力されると、「こんにちは」という音声が再生されます。音声合成は、日本語や英語などの複数の言語に対応しています。

・音声生成

音声生成とは、テキストだけでなく画像や動画などのメディアに対しても音声を生成する機能です。GPT-4Vでは、音声生成を利用することで、さまざまなメディアに関するコメントや解説などの音声を生成できます。例えば、「この画像は何ですか?」という質問に対して、「この画像は猫です。白い毛と黒い目が特徴的です」という音声が生成されます。音声生成は、日本語や英語などの複数の言語に対応しています。

「名探偵のアガサ博士は犯人ですか?」と質問したらその回答がすごいw

AI同士で会話を始めることも・・・

AI同士で構想を練ることも可能ですね!!

GPT-4V(ビジョン)でできること10選を口コミから集めてみた。

宿題を代わりにやってもらうことも可能!!

画像についてのアドバイスをもらう事もできる!

画像からアプリを作ってもらう事もできる!

グラフを作ってもらう事も可能!

画像から視覚情報を説明してもらう!

読みにくい文字を解読してもらえる!

楽譜を解説してもらえる!

車の危険予知の可能性

ホワイトボードの文字を読み取ってもらう

手書きのUI文字からHTML,CSSを抽出する

GPT-4V(ビジョン)のおすすめの活用事例10選

GPT-4Vは画像とテキストの間の関係を理解し、相互に変換することができるAIです。これにより、従来の画像認識では実現できなかった様々な応用が可能になります。

では、具体的にどのような応用があるのでしょうか?ここでは、実際に執筆者であるきょろが実際に試してすごいと感じたGPT-4Vの画像認識機能の活用事例を10個紹介します。

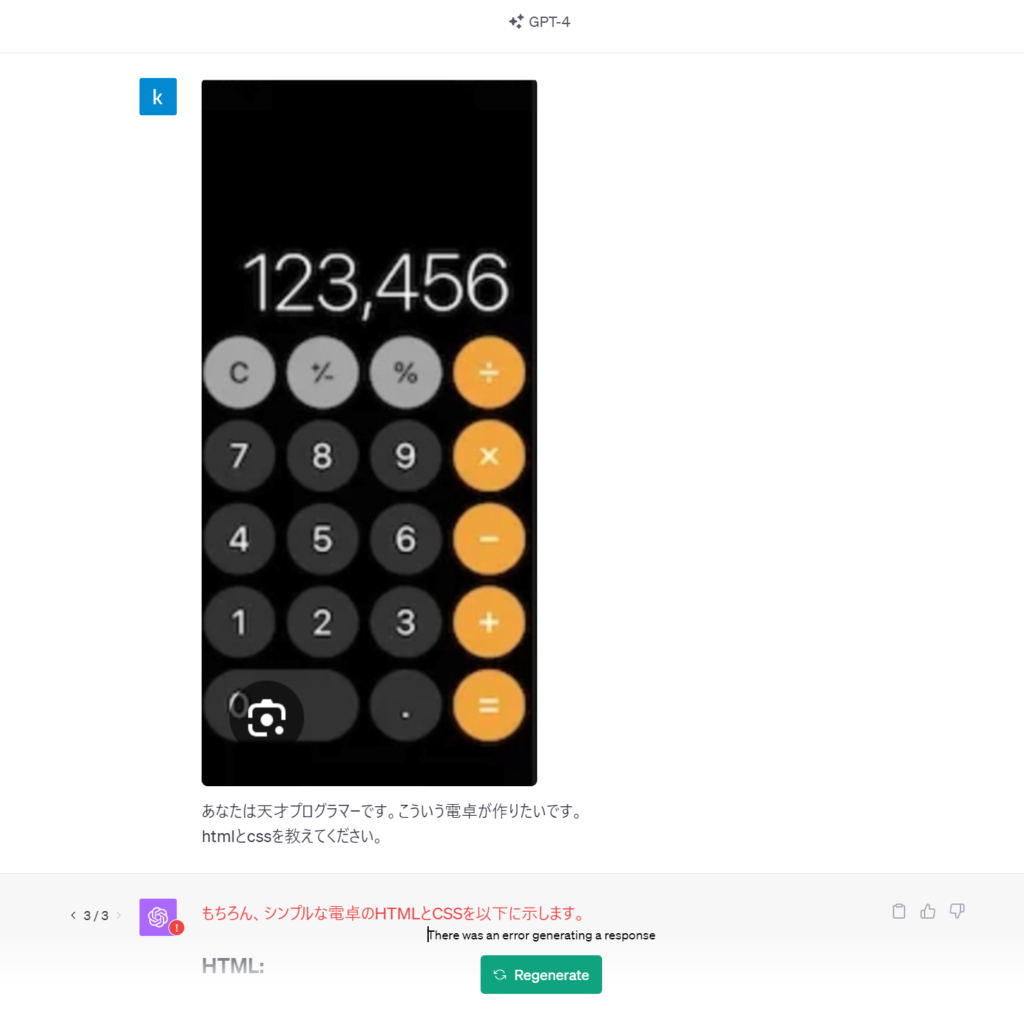

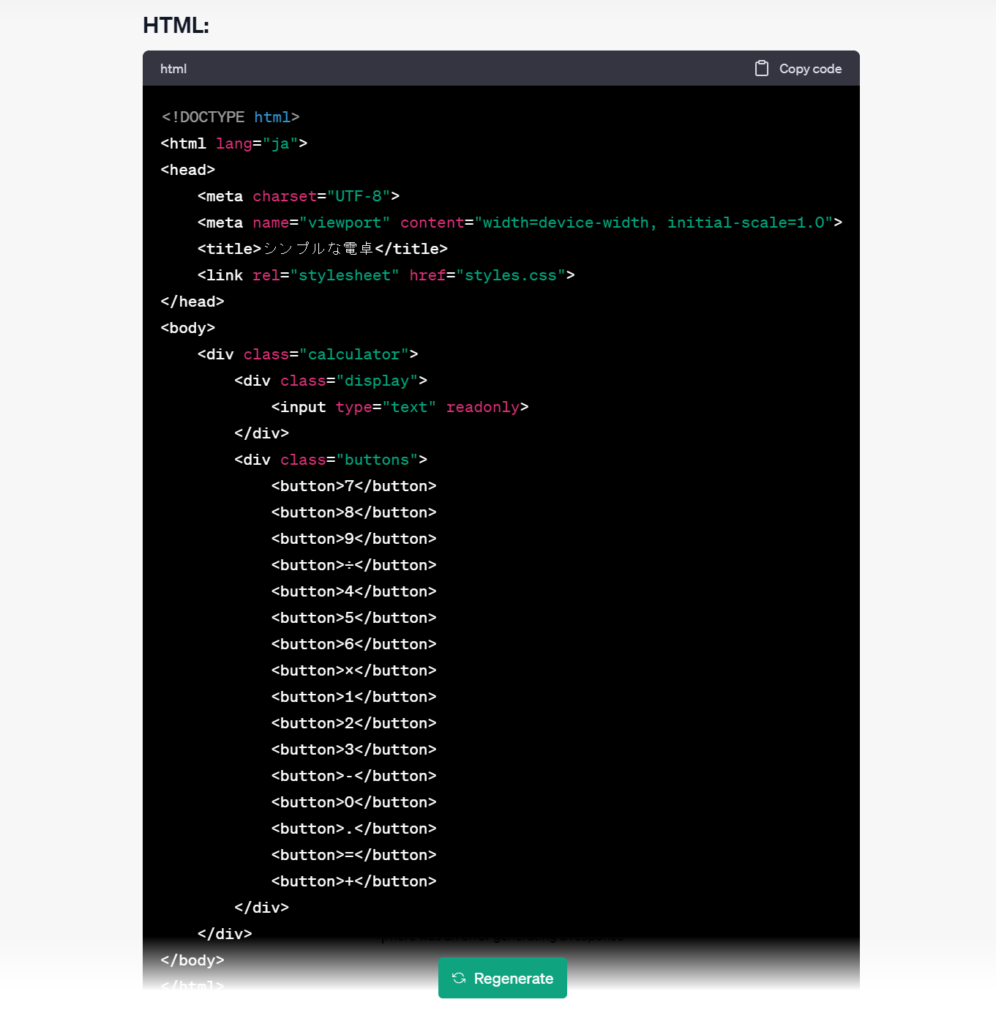

1. 画像からコード(html,css)を生成する

プログラミングを学ぶ際には、サンプルコードを参考にすることが重要です。しかし、サンプルコードを探すのは時間がかかったり、自分の目的に合わなかったりすることがあります。

そこで、GPT-4Vを使えば、自分が作りたいプログラムのイメージを画像で表現し、それに対応するサンプルコードを生成させることができます。例えば、以下のような画像から、電卓のhtmlとCSSを教えてもらいました。

あなたは天才プログラマーです。こういう電卓が作りたいです。 htmlとcssを教えてください。

こんな感じでhtmlとCSSを作ってもらいました。

2. 画像の内容を説明させることが可能

画像認識の基本的な応用として、画像の内容をテキストで説明させることがあります。これは、視覚障害者のための支援や、画像検索や画像管理などの目的で利用されます。

しかし、従来の画像認識では、画像の内容を単純なキーワードやラベルで表現することが多く、詳細な説明や背景知識は提供できませんでした。

そこで、GPT-4Vを使えば、画像の内容をより詳細かつ自然な文章で説明させることができます。例えば、以下のような画像から、文章を生成させることができます。

例えば下記の海でスイカ割をしている男女の画像を説明させてみました。

回答としては下記の通りです。これはすごい。

この画像は、ビーチで楽しんでいる2人の子供を描いています。左側には、水着を着て笑顔でパラソルの下に座っている女の子がいます。彼女の近くには、青い浮き輪と赤いカニがいます。また、右側には、黄色い水着を着て、手に木の棒を持っている男の子がいます。彼は何かを打つ姿勢をしており、顔には元気な表情があります。背景には、青い海、白い鳥、遠くには帆船も見えます。そして、砂浜にはスイカと美しい赤い花があります。全体的に、この画像は夏のビーチでの楽しい一時を表しているようです。

最近ではウェブアクセシビリティが重視されてきており障害者にとってインターネットが心地良いものが義務付けられてくる日本においてこの技術はまさに必要不可欠なものですね。

3.インテリアの改善案

GPT-4Vには、インテリアの改善案を提案する機能があります。これは、部屋の模様替えや家具の購入などに役立ちます。例えば、以下のような画像を入力し、「この部屋のインテリアを改善する方法を教えてください。」という要求を入力すると、以下のような応答が返されます。

この部屋はすでにモダンでスタイリッシュにデザインされていますが、さらに改善する方法はいくつかあります:

- 色彩の追加: 部屋にもう少し色を追加して、もっと暖かみと活気を出すことができます。例えば、カラフルなクッションやラグ、アート作品を使用するといいかもしれません。

- 植物の追加: 部屋に植物を追加すると、空間が生き生きとして自然な雰囲気になります。大きな鉢植えの植物や、窓辺に小さな植物を置くのも良い選択です。

- 照明: 照明は空間の雰囲気に大きな影響を与えます。暖かみのある光のフロアランプやテーブルランプを追加すると、部屋がもっと居心地の良い空間になるでしょう。

- カーテン: カーテンを使って窓を装飾すると、部屋がもっと豊かで完成された印象になります。ファブリックの選び方やカラーに注意を払いましょう。

- アートと装飾: 壁にアートを掛けたり、棚やテーブルに装飾品を置いたりすると、部屋に個性と特徴が出ます。

- ラグの使用: フロアにラグを置くと、部屋がもっと暖かく感じられ、空間がより定義されます。

これらの提案を参考にして、部屋のインテリアをさらに美しく、快適にすることができるでしょう。

さらに応用技も・・・

【ChatGPT All Tools】使い方 GPT-4の全機能の重ね技を徹底解説

4.サイト改善案のアドバイス

実は画像からサイトの改善アドバイスもできるんです。

例えばAIワークスタイルのTOP画像の改善アドバイスをもらうことにしました。

「このサイトの中でも特に二枚目の画像をクリックしてもらいたいのですが、アドバイスください。

尚、一般的なアドバイスは禁止です。」

ここで重要なのが「クリックしてほしいボタンの画像の提示」と「一般的なアドバイスは禁止」と伝える事です。

これめちゃ良いツールなので是非、ご活用ください。(笑)

【きょろ式】ChatGPTプロンプトテンプレート簡単生成ツール

回答はこんな結果が返ってきました。

ボタンのクリック率を向上させるために以下の点を試してみるといいかもしれません:

- 色のコントラスト: テキストと背景の色のコントラストを上げると、テキストがより読みやすくなります。

- テキストのサイズ: テキストのフォントサイズを大きくして、視覚的に目立たせます。

- ボタンのサイズ: ボタンを大きくすると、画像内でより目立つ要素になります。

- コール・トゥ・アクション(CTA): CTA(Click)が魅力的であり、クリック後に何が起こるかを明確に伝えていることを確認します。

- ボタンの形とスタイル: より多くのクリックを得るために、異なるボタンの形やスタイル(例:角の丸いボタン)を試してみます。

- 画像やアイコン: ボタンにクリックアクションを視覚的に示すために、ボタンの上や近くに矢印やマウスのアイコンを追加することを検討します。

異なるバージョンをA/Bテストして、どれが最も効果的か確認することを忘れないでください!

しかも画像も作成しもらえる!!

これはGPT-4Vの機能ではありませんが、2023年10月31日よりGPT-4V上でこんな機能が使えるようになりました。詳しい詳細は下記の記事をご参照ください。

【ChatGPT All Tools】使い方 GPT-4の全機能の重ね技を徹底解説

GPT-4V(ビジョン)、課金したのに使えない!

2023年9月28日現在、正確には順次機能が実装されるようです。

実際にTwitterでもまだ使えない・・・という声もあるようです。

おそらくGPT-4内でそれっぽい機能が使える事で混乱を招いている可能性があります。

GPT-4V(ビジョン)は無料で使える?

GPT-4Vは、ChatGPTの有料プランであるChatGPT Plusに登録しているユーザーが利用できる新機能です。ChatGPT Plusの料金は月額3,000円(2023年11月現在)です。サブスクリプション方式となっているので解約するまで料金が発生することに注意しましょう。解約はいつでもできます。ChatGPT Plusの登録や解約の方法などはこちらの記事で詳しく説明していますので参考にしてください。

GPT-4Vでは、画像を入力することでその内容を読み取り、テキストや音声で応答します。また、テキストから画像を生成することもできます。これらの機能はDALL·E 3と呼ばれるビジュアル言語モデル(VLM)によって実現されています。DALL·E 3は、画像とテキストのペアで学習したGPT-4の拡張版です。

有料課金の方法はこちら。

ChatGPT Plus(有料版)の料金や支払い方法について徹底解説

GPT-4V(ビジョン)の安全性確保の取り組みは?

OpenAIの厳格な内部検証

GPT-4Vの安全性は、OpenAIの緻密な内部検証を通じて確認されています。この検証の結果、GPT-4Vはテキストに関する現行のポリシーの遵守において、基本的な言語モデルと変わらない性能を持つことが確認されました。また、システム全体として、モデレーション分類器が後段の監督と適用のプロセスに貢献しています。

外部エキスパートの意見

OpenAIは外部の専門家と共同で、モデルとシステムの制約やリスクを詳細に検討しています。この「レッドチーム戦略」は、特にGPT-4Vの多機能性(視覚機能を含む)のリスクを検証する目的で行われています。

「レッドチーミング」とは、外部からの視点で組織のセキュリティ手段や方針を検証・試験するアプローチを指します。専門家で構成される「レッドチーム」が仮想の攻撃者として行動し、組織の弱点を特定します。この手法により、組織はセキュリティの脆弱性を把握し、対策を強化することができます。

リスクの特性 GPT-4Vには、例として医療や専門的な科学分野など、特定の高度な領域での性能が大幅に上昇している可能性が指摘されています。また、人の画像に関するリスク、例えば個人の特定や、画像に起因する損失の減少も考慮されています。

安全性の向上と対応

GPT-4Vは、GPT-4やDALL-Eに採用されているモデルやシステムの安全対策をいくつか継承しています。テキストや画像がそれぞれ無害であっても、組み合わせることで有害な出力が生じる可能性にも対応しています。

下記内容はOpenAIの公式見解について、GPT-4Vに関する論文情報をもと要約したものです。

- 科学的知識:GPT-4Vは、危険な化学物質の情報を提供することができます。しかし、その情報は必ずしも正確ではないため、危険な目的での使用は避けるべきです。

- 医療情報:医療に関するアドバイスも提供しますが、その正確性は保証されません。健康に関する重要な判断は、専門家の意見を求めるべきです。

- 偏見の問題:提供される情報が偏見を持っている可能性があります。ユーザーは、情報の正確性や公平性を常に確認する必要があります。

- 誤情報のリスク:GPT-4Vが提供する情報が、常に正確であるとは限りません。

- 不適切な内容:憎悪的な内容を生成する可能性が考えられます。

- 視覚的な問題:画像を使うことで、新しいリスクが生じるかもしれません。

これらのリスクを理解し、適切に対応することが大切です。

引用:GPT-4V(ision) System Card

現状:GPT-4のここが弱い!画像処理能力が不十分

GPT-4Vは驚異的な性能を発揮するモデルですが、今現在のGPT-4を他社生成AIツールと比較するとまだ弱点や改善点があります。どれほど機能が向上するのかワクワクしますね。

ここでは、代表的な弱点を紹介します。

GPT-4は画像処理能力を持っていますが、それでもまだ完全ではありません。例えば、以下のような問題があります。

画像の解像度や品質が低い

画像に含まれる物体や人物が多すぎる

画像に含まれる物体や人物が小さすぎる

画像に含まれる物体や人物が不明瞭な

画像に含まれる物体や人物が珍しい

実際にBingAIにも画像認識機能が付きましたが、今現在の機能差は正直圧倒的にBingAIに軍配を上げたいと考えています。

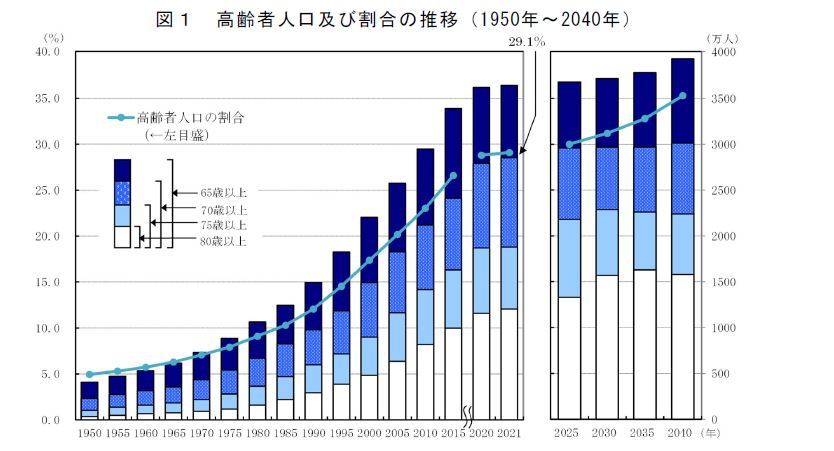

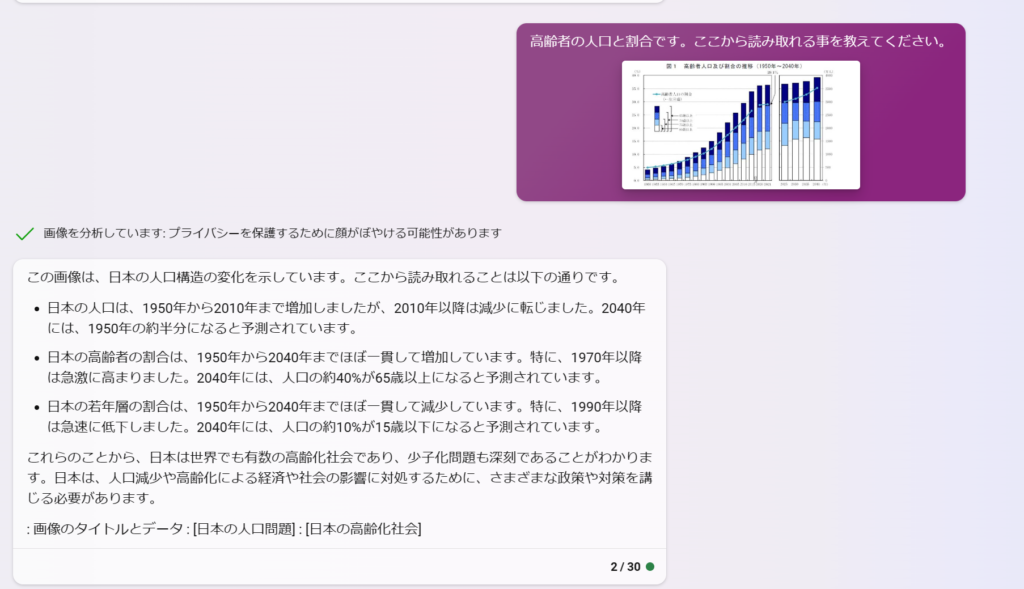

例えば下記は総務省から拝借した「高齢者人口の割合の推移」の画像を分析させてみました。

総務省より引用

実際に下記のような回答が返ってきました。

この画像は、日本の人口構造の変化を示しています。ここから読み取れることは以下の通りです。

・日本の人口は、1950年から2010年まで増加しましたが、2010年以降は減少に転じました。2040年には、1950年の約半分になると予測されています。

・日本の高齢者の割合は、1950年から2040年までほぼ一貫して増加しています。特に、1970年以降は急激に高まりました。2040年には、人口の約40%が65歳以上になると予測されています。

・日本の若年層の割合は、1950年から2040年までほぼ一貫して減少しています。特に、1990年以降は急速に低下しました。2040年には、人口の約10%が15歳以下になると予測されています。

これらのことから、日本は世界でも有数の高齢化社会であり、少子化問題も深刻であることがわかります。日本は、人口減少や高齢化による経済や社会の影響に対処するために、さまざまな政策や対策を講じる必要があります。

かなり高度な回答ができますね。また何よりこれが無料で使えるとなると・・・

BingAIの画像認識機能の使い方と詳細は下記をご覧ください。

ChatGPTのGPT-4Vを使ったユーザーの声

実際に使えたという声もあるそうで、順次機能が実装されている可能性はあります。

エンジニアが救われる未来が見えてきたぞ・・・

これは・・・セキュリティ要素が今後どうなるのか・・・

ん~やっぱり画像認識機能はまだ弱いですね!

※ちなみに現在では2022年までの情報でしか回答できないそうです。

ChatGPTのGPT-4Vによってどんな社会影響がある?

ChatGPTのGPT-4Vによって、ChatGPTはどのような変化が起きるのでしょうか?以下に、代表的な変化を紹介します。

チャットの幅が広がる

ChatGPTでは、テキストだけでなく画像も入力として受け取ることができます。また、テキストだけでなく音声や画像も出力として生成することができます。これによって、チャットの幅が広がります。例えば、以下のようなことができます。

画像からテキストを生成する

テキストから画像を生成する

画像から音声を生成する

音声から画像を生成する

画像から画像を生成する

これらのことは、従来のチャットではできなかったことです。これらのことによって、チャットはより多様で豊かになります。

チャットの質が向上する

ChatGPTでは、テキストと画像の両方を理解することができます。また、テキストと画像の両方を生成することができます。これによって、チャットの質が向上します。例えば、以下のようなことができます。

画像に対するコメントや解説などのテキストを生成する

テキストに対するイメージやイラストなどの画像を生成する

画像に関する音声や音楽などの音声を生成する

音声に関する画像や動画などのメディアを生成する

これらのことは、従来のチャットではできなかったことです。これらのことによって、チャットはより正確で自然になります。

GPT-4V(ビジョン)まとめ

ChatGPTの画像認識機能であるGPT-4Vについて紹介しました。GPT-4Vは、テキストだけでなく画像も理解することができる最新のマルチモーダルAIモデルです。是非、使ってみてください。!

おすすめ講座

\ ホリエモンプロデュース!ChatGPTのオンラインスクール開講 /

ChatGPTを仕事で活かしたい、学校で活かしたい方必見!

月額制で約100講義の生成AI講座が見放題 !!

専用のサポートコミュニティで24時間質問し放題!!!

堀江貴文氏監修のChatGPTオンラインスクール

趣味:業務効率化、RPA、AI、サウナ、音楽

職務経験:ECマーチャンダイザー、WEBマーケティング、リードナーチャリング支援

所有資格:Google AI Essentials,HubSpot Inbound Certification,HubSpot Marketing Software Certification,HubSpot Inbound Sales Certification

▼書籍掲載実績

Chrome拡張×ChatGPTで作業効率化/工学社出版

保護者と教育者のための生成AI入門/工学社出版(【全国学校図書館協議会選定図書】)

突如、社内にて資料100件を毎月作ることとなり、何とかサボれないかとテクノロジー初心者が業務効率化にハマる。AIのスキルがない初心者レベルでもできる業務効率化やAIツールを紹介。中の人はSEO歴5年、HubSpot歴1年